Künstliche Intelligenz

Wir dürfen KI nicht entwickeln, um Menschen zu ersetzen.

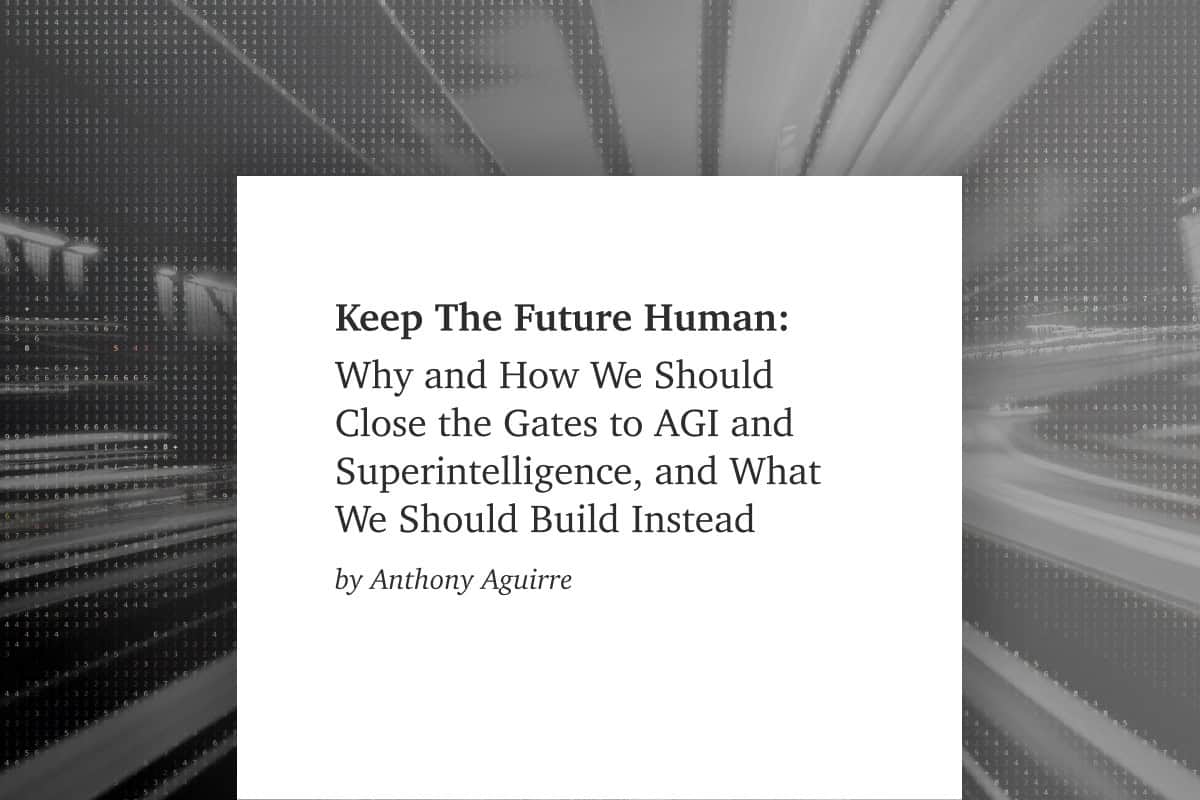

Die Menschheit steht kurz davor, eine künstliche allgemeine Intelligenz zu entwickeln, die unsere eigene übertrifft. Es ist an der Zeit, die Tore zu AGI und Superintelligenz zu schließen... bevor wir die Kontrolle über unsere Zukunft verlieren.

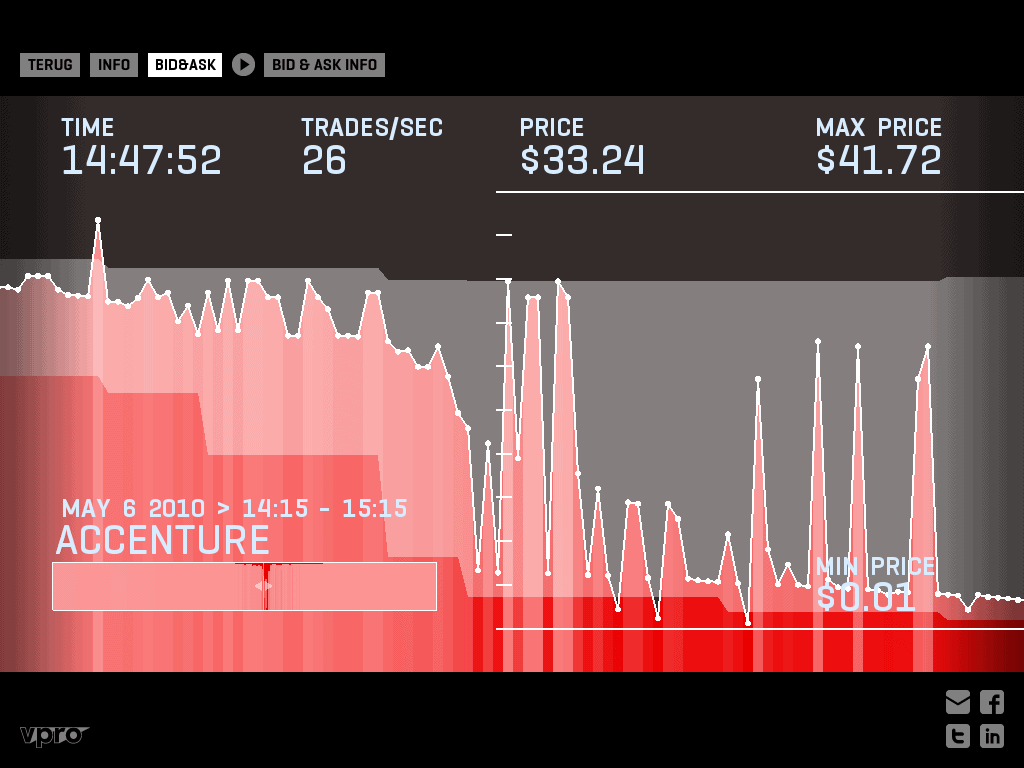

Künstliche Intelligenz ist auf dem Vormarsch. Unternehmen entwickeln zunehmend vielseitig einsetzbare KI-Systeme, die viele verschiedene Aufgaben erfüllen können. Große Sprachmodelle (engl.: large language models, LLMs) können Gedichte verfassen, Kochrezepte erstellen und Computercode schreiben. Von einigen dieser Modelle gehen bereits heute große Gefahren aus, z. B. die Erosion demokratischer Prozesse, das Grassieren von Verzerrungen und Fehlinformationen sowie ein Wettrüsten im Bereich der autonomen Waffen. Aber noch Schlimmeres zeichnet sich ab.

KI-Systeme werden nur noch leistungsfähiger werden. Unternehmen bemühen sich aktiv um die Schaffung einer "artificial general intelligence" (AGI, zu deutsch: allgemeine künstliche Intelligenz), die eine Vielzahl von Aufgaben genauso gut oder besser als der Mensch ausführen kann. Diese Unternehmen versprechen, dass diese Technologie ungeahnte Vorteile bringen wird, von der Krebsheilung bis zur Beseitigung der weltweiten Armut. Auf der anderen Seite glaubt mehr als die Hälfte der KI-Experten, dass AGI mit einer zehnprozentigen Wahrscheinlichkeit das Ende unserer Spezies bedeuten wird.

Diese Überzeugung hat nichts mit den bösen Robotern oder empfindungsfähigen Maschinen zu tun, die man aus der Science-Fiction kennt. Kurzfristig kann fortgeschrittene KI diejenigen, die Schaden anrichten wollen – zum Beispiel Bioterroristen – ermächtigen, indem sie es erlaubt, gewissenlos hochkomplexe Prozesse auszuführen.

Längerfristig sollten wir uns nicht auf eine bestimmte Art von Schaden fixieren, denn die Gefahr geht von höherer Intelligenz selbst aus. Denken Sie daran, wie Menschen weniger intelligente Tiere dominieren, ohne sich auf eine bestimmte Waffe zu verlassen, oder wie ein KI-Schachprogramm menschliche Spieler besiegt, ohne sich auf einen bestimmten Zug zu verlassen.

Das Militär könnte die Kontrolle über ein hochleistungsfähiges System verlieren, das auf Zerstörung programmiert ist, was verheerende Folgen hätte. Ein hochentwickeltes KI-System mit der Aufgabe, Unternehmensgewinne zu maximieren, könnte drastische, unvorhersehbare Methoden anwenden. Selbst eine KI, die auf altruistisches Handeln ausgelegt ist, könnte dieses Ziel auf zerstörerische Weise erreichen. Wir können derzeit nicht wissen, wie sich KI-Systeme verhalten werden, weil niemand versteht, wie sie funktionieren. Nicht einmal ihre Schöpfer.

KI-Sicherheit ist inzwischen als Anliegen im Mainstream angekommen. Experten und die breite Öffentlichkeit sind sich einig in ihrer Besorgnis über die entstehenden Risiken und die dringende Notwendigkeit, diese zu bewältigen. Aber Besorgnis allein wird nicht ausreichen. Wir brauchen politische Maßnahmen, die dabei helfen sicherzustellen, dass KI-Entwicklung das Leben aller verbessert – und nicht bloß die Gewinne einiger Unternehmen steigert. Außerdem brauchen wir angemessene Governance, einschließlich einer robusten Regulierung und fähigen Institutionen, die diese transformative Technologie weg von extremen Risiken und hin zum Wohl der Menschheit lenken können.

Andere Schwerpunktbereiche

Atomwaffen

Biotechnologie

Aktuelle Inhalte zu Künstlicher Intelligenz

Beiträge

Stehen wir kurz vor einer Intelligenzexplosion?

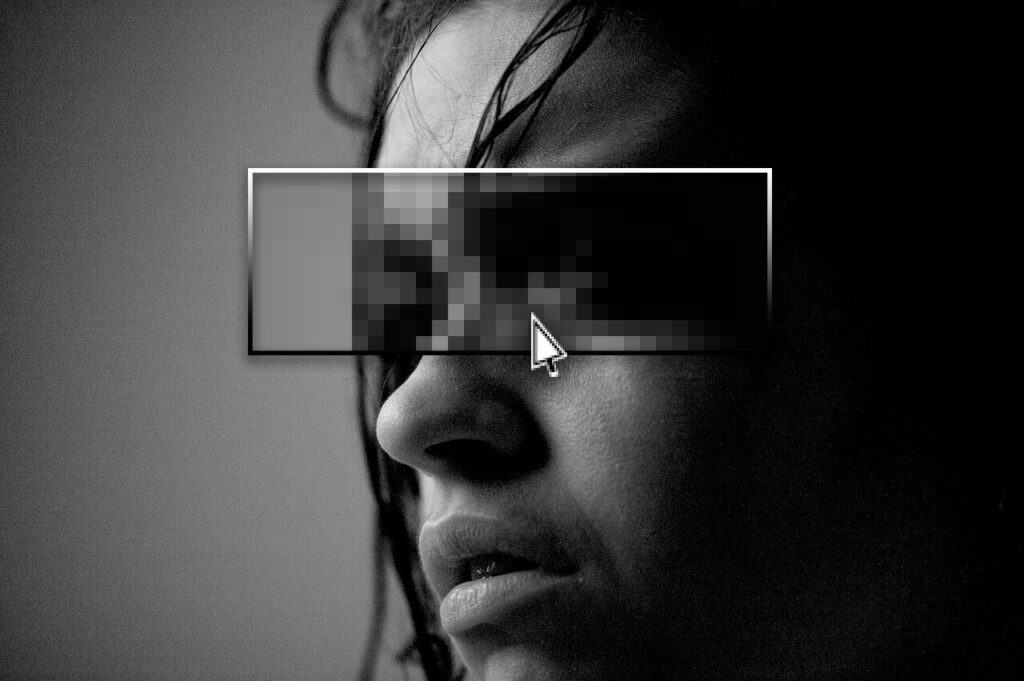

Unterbrechung der Deepfake-Lieferketten in Europa

Realisierung erstrebenswerter Zukunftsvisionen - Neue FLI-Fördermöglichkeiten

Allmähliche Entmachtung der KI

Erforschung von sicheren Hardware-Lösungen für den sicheren Einsatz von KI

Schützen Sie das EU KI-Gesetz

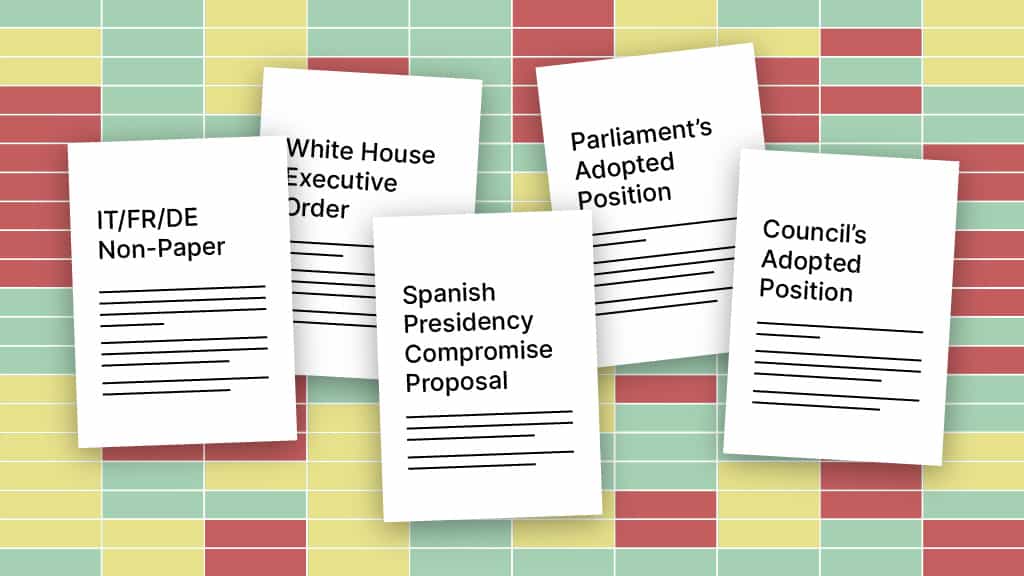

Meilenweit auseinander: Ein Vergleich von europäischen KI-Gesetzesvorschlägen

Können wir uns auf den Informationsaustausch verlassen?

Ressourcen

Katastrophale KI-Szenarien

Einführende Ressourcen zu KI-Risiken

Globale KI-Politik

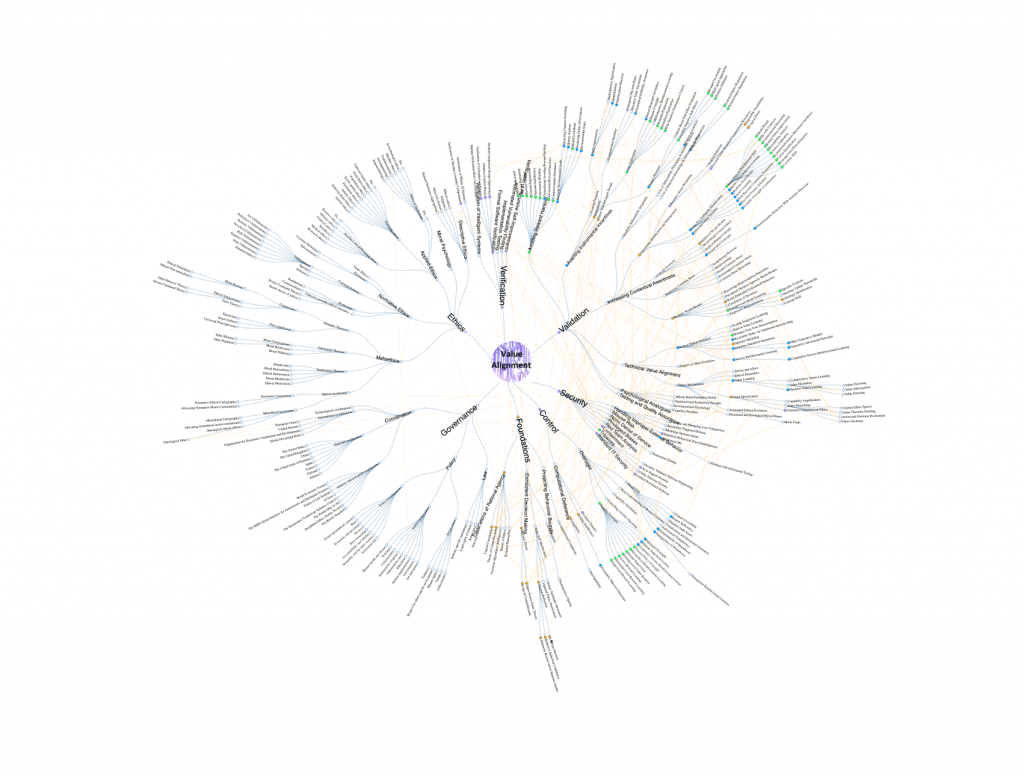

Forschungslandschaft im Feld von AI-Alignment

Positionspapiere

Wettbewerb in der generativen KI: Feedback des Future of Life Institutes zur Konsultation der Europäischen Kommission

Manifest für die Europäische Kommission 2024-2029

FLI Antwort an OMB: Bitte um Kommentare zu KI-Governance, Innovation und Risikomanagement

FLI Antwort an NIST: Bitte um Informationen über den Auftrag des NIST im Rahmen der AI Executive Order

Videos (engl.)

Podcasts