Unsere Mission

Wir wollen transformative Technologie lenken, sodass sie dem Leben zugutekommt und extreme Risiken vermeidet.

Wir glauben, der wichtigste Faktor für die Zukunftsaussichten des Lebens wird die Herangehensweise sein, mit der transformative Technologien entwickelt und eingesetzt werden. Deshalb haben wir es uns zur Aufgabe gemacht, dafür zu sorgen, dass sich diese Aussichten weiter verbessern.

Neueste Updates

Aktuelles

Der Präsident des FLI, Max Tegmark, und der Direktor für Politik, Mark Brakel, nahmen an dem Bericht "The Singapore Consensus on Global AI Safety Research Priorities" teil. Der Bericht legt eine Agenda für die wichtigste KI-Sicherheitsforschung fest, die heute benötigt wird und die von über 100 führenden KI-Forschern und Wissenschaftlern festgelegt wurde. Sehen Sie sich die Forschungsprioritäten hier an, oder lesen Sie darüber in WIRED.

Schwerpunktbereiche

Die Risiken, auf die wir uns konzentrieren

Derzeit beschäftigen wir uns mit drei großen Risiken. Für sie alle ist die Entwicklung, der Einsatz und die Steuerung von transformativen Technologien ein Dreh- und Angelpunkt. Wir konzentrieren unsere Bemühungen darauf, die Auswirkungen dieser Technologien zu lenken.

Künstliche Intelligenz

Von Empfehlungsalgorithmen über Chatbots bis hin zu selbstfahrenden Autos – KI verändert unser Leben. Während die Technologie immer mehr an Bedeutung gewinnt, werden auch die damit verbundenen Risiken größer.

Künstliche Intelligenz

Biotechnologie

Vom versehentlichen Freilassen künstlicher Erreger bis hin zu katastrophalen Folgen von gentechnischen Experimenten – die Gefahren der Biotechnologie sind zu groß, um blind voranzuschreiten.

Biotechnologie

Atomwaffen

Fast achtzig Jahre nach ihrer Entwicklung sind die Risiken, die von Atomwaffen ausgehen, so hoch wie eh und je – und neue Forschungsergebnisse zeigen, dass die Auswirkungen eines Atomkriegs noch schlimmer wären als bisher angenommen.

Atomwaffen

Autonome Drohnen vom Typ UAV Kargu auf dem Campus des OSTIM Technopark in Ankara, Türkei - Juni 2020.

Unsere Arbeit

Wie wir diese Probleme angehen

Es gibt viele potenzielle Ansatzpunkte, um die Entwicklung und den Einsatz von transformativen Technologien zu steuern. Wir setzen an einer Reihe dieser Punkte an, um unsere Erfolgschancen zu erhöhen.

Politik und Forschung

Wir engagieren uns in den Vereinigten Staaten, der Europäischen Union und auf der ganzen Welt in der Politikberatung und Forschung.

Unsere Politik- und ForschungsarbeitOutreach

Wir produzieren Bildungsmaterialien, die den öffentlichen Diskurs informieren und Menschen ermutigen sollen, sich zu engagieren.

Unsere Outreach-ArbeitVergabe von Förderung

Wir vergeben Fördergelder an Einzelpersonen und Organisationen, die an Projekten arbeiten, die unserem Mission vorantreiben.

Unsere FörderprogrammeZukunftsvisionen

Unser Zukunftsprogramm zielt darauf ab, die Menschheit zur Realisierung der positiven Möglichkeiten zu führen, die durch transformative Technologien entstehen.

Unsere Arbeit für die Zukunft

Spotlight

Wir dürfen KI nicht entwickeln, um Menschen zu ersetzen.

Ein neuer Essay von Anthony Aguirre, Geschäftsführer des Future of Life Institute

Die Menschheit steht kurz davor, eine künstliche allgemeine Intelligenz zu entwickeln, die unsere eigene übertrifft. Es ist an der Zeit, die Tore zu AGI und Superintelligenz zu schließen... bevor wir die Kontrolle über unsere Zukunft verlieren.

Ausgewählte Projekte

Woran wir arbeiten

Informieren Sie sich über einige unserer aktuellen Projekte:

Religiöse Perspektiven auf eine positive KI-Zukunft

Der Großteil der Weltbevölkerung gehört einer Religion an. Dennoch sind die Perspektiven dieser Religionen in den strategischen Diskussionen über künstliche Intelligenz weitgehend abwesend. Diese Initiative zielt darauf ab, religiöse Gruppen dabei zu unterstützen, ihre glaubensspezifischen Bedenken und Hoffnungen für eine Welt mit KI zu äußern und mit ihnen zusammenzuarbeiten, um Schäden abzuwenden und Vorteile zu realisieren.

Empfehlungen für den AI-Aktionsplan der USA

Der Vorschlag des Future of Life Institute für den KI-Aktionsplan von Präsident Trump. Unsere Empfehlungen zielen darauf ab, die Präsidentschaft vor dem Kontrollverlust über KI zu schützen, die Entwicklung von KI-Systemen frei von ideologischen oder sozialen Agenden zu fördern, amerikanische Arbeitnehmer vor Arbeitsplatzverlust und Ersatz zu schützen und vieles mehr.

Engagement mehrerer Interessengruppen für eine sichere und prosperierende KI

Das FLI lanciert neue Stipendien, um Interessengruppen und die breite Öffentlichkeit für eine sichere und nützliche KI zu sensibilisieren und zu gewinnen.

Digital Media Accelerator

Der Digital Media Accelerator unterstützt digitale Inhalte von Urhebern, die das Bewusstsein und das Verständnis für aktuelle KI-Entwicklungen und -Themen fördern.

FLI AI-Sicherheitsindex 2024

Sieben KI- und Governance-Experten bewerten die Sicherheitspraktiken von sechs führenden KI-Unternehmen für allgemeine Zwecke.

KI-Konvergenz: Risiken am Schnittpunkt von KI zu nuklearen, biologischen und Cyber-Bedrohungen

Das Gefahrenpotenzial von KI-Systemen kann die Gefahrenpotenziale anderer Technologien verstärken – dies wird als KI-Konvergenz bezeichnet. Wir bieten politischen Entscheidungsträgern in den Vereinigten Staaten politische Expertise in drei wichtigen Konvergenzbereichen: Bio-, Nuklear- und Cybertechnologien.

Wettbewerb zu Visonen der Superintelligenz

Ein Wettbewerb für die besten Bildungsmaterialien zum Thema

Superintelligenz, die damit verbundenen Risiken und die Auswirkungen

dieser Technologie auf unsere Welt. Fünf Preise zu je 10.000 $.

Der Brief der Ältesten zu existenziellen Bedrohungen

Die Ältesten, das Future of Life Institute und eine Reihe herausragender Persönlichkeiten des öffentlichen Lebens fordern die Staats- und Regierungschefs der Welt auf, sich dringend mit den anhaltenden Schäden und eskalierenden Risiken durch die Klimakrise, Pandemien, Atomwaffen und unkontrollierte künstliche Intelligenz auseinanderzusetzen.

Umsetzung des europäischen AI-Gesetzes

Zu unseren wichtigsten Empfehlungen gehören die Ausweitung des Geltungsbereichs des Gesetzes zur Regulierung von allgemeinen KI-Systemen, sowie die Ausweitung der Definition verbotener Manipulation auf alle Arten von Manipulationstechniken sowie auf Manipulationen, die gesellschaftlichen Schaden verursachen.

Aufklärungsarbeit über autonome Waffensysteme

Militärische KI-Anwendungen breiten sich rasch aus. Wir entwickeln Bildungsmaterial darüber, wie bestimmte Klassen von KI-gesteuerten Waffen der nationalen Sicherheit schaden und die Zivilisation destabilisieren können, wie etwa Waffen, bei denen Tötungsentscheidungen vollständig an Algorithmen delegiert werden.

Globale KI-Governance bei den UN

Unsere Beteiligung an der Arbeit der Vereinten Nationen erstreckt sich über mehrere Jahre und Initiativen, darunter die Roadmap for Digital Cooperation und der Global Digital Compact (GDC).

Der Future of Life Award

Jedes Jahr wird dieser Preis an einen oder mehrere unbesungene Helden verliehen, die einen bedeutenden Beitrag zur Erhaltung der Zukunft des Lebens geleistet haben.

Alle Projekte anzeigen

Newsletter

Regelmäßige Updates zu den Technologien, die unsere Welt verändern

Jeden Monat informieren wir mehr als 41.000 Abonnenten über die neuesten Entwicklungen im Bereich neuer Technologien, die unsere Welt verändern. Der Newsletter enthält eine Zusammenfassung der wichtigsten Entwicklungen in unseren Problembereichen und wichtige Updates zu unserer Arbeit. Abonnieren Sie unseren Newsletter, um diese Highlights am Ende jeden Monats zu erhalten.

Newsletter Future of Life Institute : Senat lehnt Verbot der KI-Regulierung ab

Außerdem: Die OpenAI Files, ein gruseliges neues InsideAI-Video und mehr.

Maggie Munro

3 Juli, 2025

Future of Life Institute Newsletter: Ein großes, schönes Gesetz ... das staatliche KI-Gesetze verbietet?!

Plus: Aktualisierungen zum Verhaltenskodex des EU-KI-Gesetzes, der Singapur-Konsens, offener Brief evangelikaler Führer und mehr.

Maggie Munro

31 Mai, 2025

Newsletter Future of Life Institute : Wo sind die Sicherheitsteams?

Plus: Online-Kurs über den Aufbau von Welten für eine positive Zukunft mit KI; neue Veröffentlichungen über KI; unser Digital Media Accelerator; und mehr.

Maggie Munro

1 Mai, 2025

Frühere Ausgaben lesen

Unsere Inhalte

Neueste Beiträge

Die neuesten Beiträge, die wir veröffentlicht haben:

Stehen wir kurz vor einer Intelligenzexplosion?

Die KI nähert sich immer mehr einer kritischen Schwelle. Jenseits dieser Schwelle lauern große Risiken - aber sie zu überschreiten ist nicht unvermeidlich.

21 März, 2025

Die Auswirkungen von KI im Bildungswesen: Navigieren in der nahen Zukunft

Was muss beachtet werden, um eine sichere, aber effektive Zukunft für KI in der Bildung und für die Sicherheit von Kindern im Internet zu schaffen?

13 Februar, 2025

Kontext und Agenda für den KI-Aktionsgipfel 2025

Der AI Action Summit wird vom 10. bis 11. Februar 2025 in Paris stattfinden. Hier finden Sie die Tagesordnung und die wichtigsten Ergebnisse.

31 Januar, 2025

Eine buddhistische Perspektive auf KI: Kultivierung der Freiheit der Aufmerksamkeit und der wahren Vielfalt in einer KI-Zukunft

Einige behaupten, dass die KI-gestützte Intelligenzrevolution die Menschheit auf einen Gleitpfad in eine utopische Zukunft mit nahezu müheloser Zufriedenheit und reibungslosen Wahlmöglichkeiten bringt. Wir sollten uns in Acht nehmen.

20 Januar, 2025

Papiere

Die jüngsten von uns veröffentlichten Strategie- und Forschungspapiere:

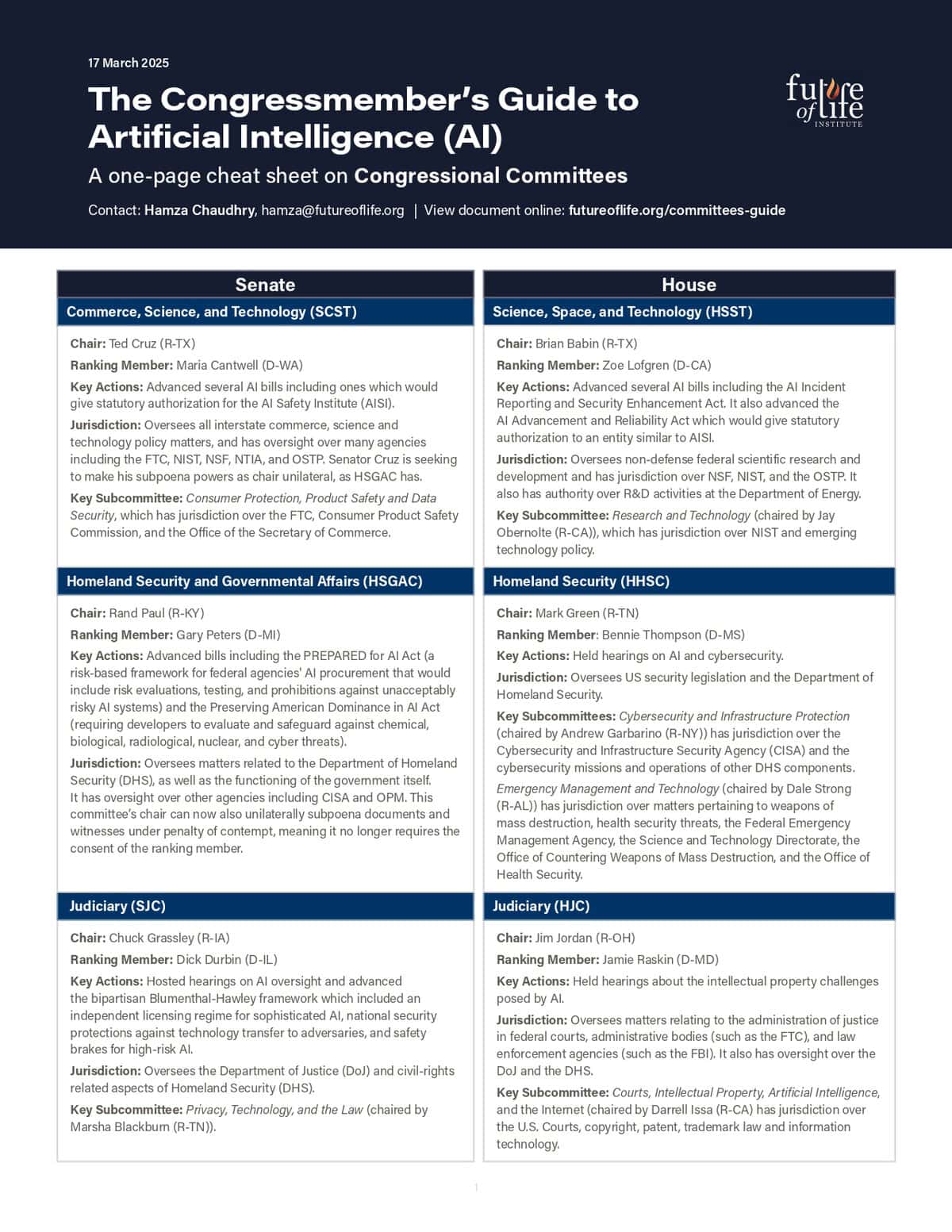

Leitfaden für Mitarbeiter zur KI-Politik: Kongressausschüsse und einschlägige Gesetzgebung

März 2025

Empfehlungen für den AI-Aktionsplan der USA

März 2025

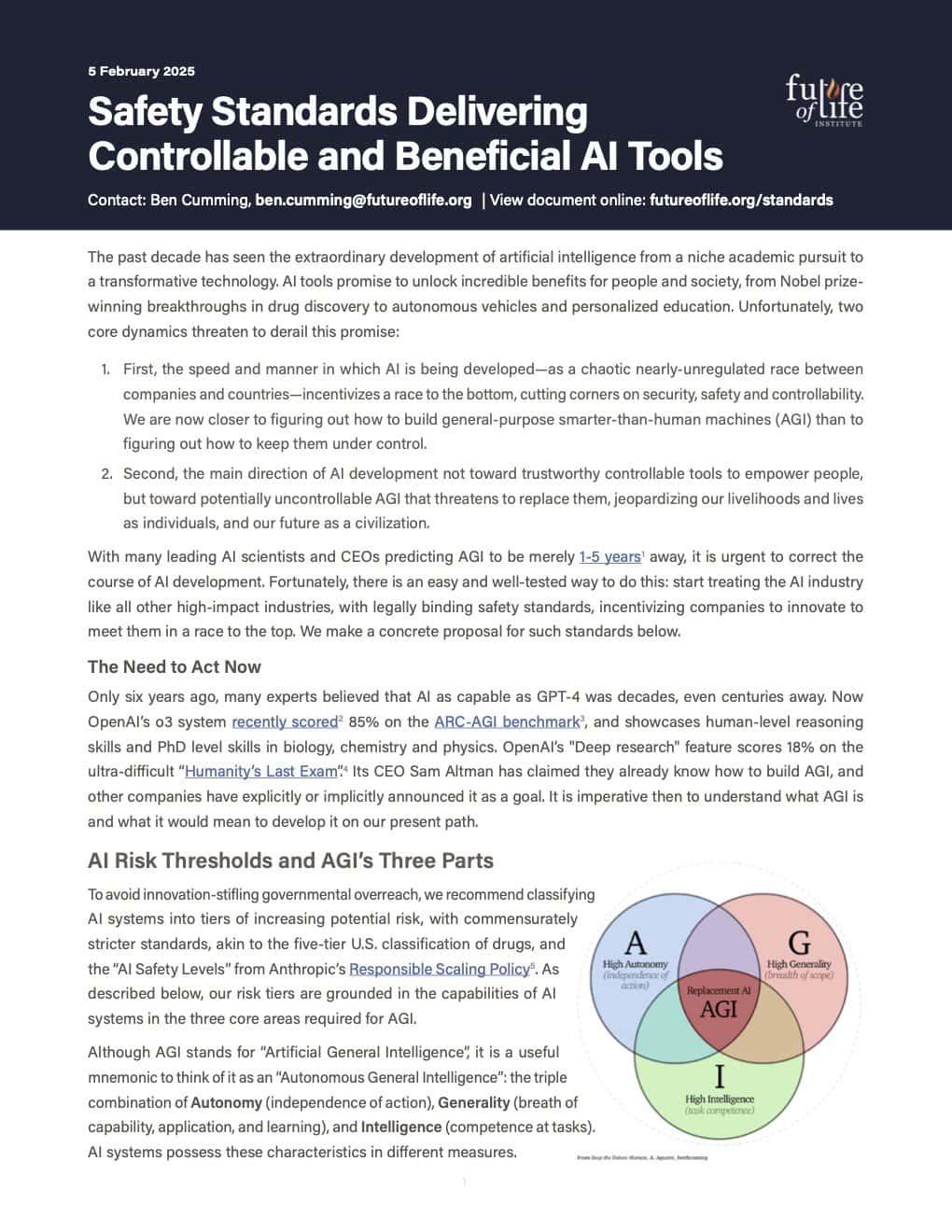

Sicherheitsstandards zur Bereitstellung kontrollierbarer und nützlicher AI-Tools

Februar 2025

Rahmen für den verantwortungsvollen Einsatz von KI im Nuklearbereich

Februar 2025

Alle Beiträge anzeigen

Future of Life Institute Podcast

Unsere neuesten Folgen:

Alle Episoden anzeigen