Notre mission

Mettre les technologies de transformation au profit de la vie et œuvrer pour qu'elles ne présentent pas de risques majeurs à grande échelle.

Nous pensons que la manière dont une technologie puissante est développée et utilisée sera le facteur le plus important pour déterminer les perspectives d'avenir de la vie. C'est pourquoi nous nous sommes donnés pour mission de veiller à ce que la technologie continue d'améliorer ces perspectives.

Mises à jour récentes

Maintenant

Max Tegmark, président de FLI, et Mark Brakel, directeur de la politique, ont participé au "Consensus de Singapour sur les priorités mondiales en matière de recherche sur la sécurité de l'IA". Le rapport établit un programme pour les recherches les plus importantes en matière de sécurité de l'IA nécessaires aujourd'hui, tel que déterminé par un rassemblement de plus de 100 chercheurs et scientifiques de haut niveau dans le domaine de l'IA. Consultez les priorités de recherche ici, ou lisez le rapport dans WIRED.

Domaines d'intervention

Les risques sur lesquels nous nous concentrons

Nous sommes actuellement préoccupés par trois risques majeurs. Ils dépendent tous du développement, de l'utilisation et de la gouvernance des technologies de transformation. Nous concentrons nos efforts sur la maîtrise des impacts de ces technologies.

Intelligence artificielle

Des algorithmes de recommandation aux chatbots en passant par les voitures autonomes, l'IA est en train de changer nos vies. Au fur et à mesure que l'impact de cette technologie s'accroît, les risques augmentent.

Intelligence artificielle

Biotechnologie

Qu'il s'agisse de la propagation accidentelle d'agents pathogènes modifiés ou de l'échec d'une expérience de modification génétique, les dangers de la biotechnologie sont trop importants pour que nous puissions agir à l'aveugle.

Biotechnologie

Armes nucléaires

Près de quatre-vingts ans après leur apparition, les risques causés par les armes nucléaires sont plus élevés que jamais, et de nouvelles recherches révèlent que les conséquences sont encore plus graves qu'on ne le pensait auparavant.

Armes nucléaires

Drones autonomes UAV Kargu sur le campus du Technoparc OSTIM à Ankara, Turquie - juin 2020.

Notre travail

Comment abordons-nous ces questions ?

Il existe de nombreuses possibilités de changement potentiels pour orienter le développement et l'utilisation des technologies de transformation. Nous nous concentrons sur certaines de ces possibilités pour augmenter nos chances de réussite.

Politique et recherche

Nous nous engageons dans la défense des politiques et la recherche aux États-Unis, dans l'Union européenne et dans le monde entier.

Notre travail politique et de rechercheSensibilisation

Nous élaborons du matériel pédagogique destiné à éclairer le discours public et à encourager les gens à s'impliquer.

Notre travail de sensibilisationOctroi de subventions

Nous accordons des subventions à des personnes et à des organisations, qui travaillent sur des projets qui soutiennent notre mission.

Nos programmes de subventionsAvenirs

Le programme Avenirs vise à guider l'humanité vers les futurs souhaitables permis par les technologies transformatrices.

Notre travail sur l'avenir

Pleins feux sur

Nous ne devons pas construire l'IA pour remplacer les humains.

Un nouvel essai d'Anthony Aguirre, directeur exécutif du Future of Life Institute

L'humanité est sur le point de développer une intelligence artificielle générale qui la dépasse. Il est temps de fermer les portes de l'AGI et de la superintelligence... avant de perdre le contrôle de notre avenir.

Projets à la une

Les projets sur lesquels nous travaillons

Découvrez quelques-uns de nos projets actuels :

Les perspectives des religions traditionnelles sur des avenirs positifs avec l'IA

La majorité de la population mondiale pratique une religion traditionnelle. Pourtant, les perspectives religieuses sont généralement absentes des discussions stratégiques sur l'IA. Cette initiative vise à aider les groupes religieux à exprimer, selon leur foi, leurs préoccupations et leurs espoirs pour un monde avec l’IA, et à collaborer avec eux pour en éviter les dérives et en réaliser les promesses.

Recommandations pour le plan d'action américain en matière d'IA

La proposition du Future of Life Institute pour le plan d'action du président Trump en matière d'IA. Nos recommandations visent à protéger la présidence contre la perte de contrôle de l'IA, à promouvoir le développement de systèmes d'IA exempts d'agendas idéologiques ou sociaux, à protéger les travailleurs américains contre la perte et le remplacement d'emplois, et plus encore.

L'engagement des parties prenantes pour une IA sûre et prospère

FLI lance de nouvelles subventions pour éduquer et engager les groupes de parties prenantes, ainsi que le grand public, dans le mouvement en faveur d'une IA sûre, sécurisée et bénéfique.

Accélérateur de médias numériques

L'accélérateur de médias numériques soutient le contenu numérique de créateurs qui sensibilisent aux développements et aux problèmes actuels de l'IA et les font mieux comprendre.

FLI Indice de sécurité de l'IA 2024

Sept experts en IA et en gouvernance évaluent les pratiques de sécurité de six grandes entreprises d'IA à vocation générale.

Convergence de l'IA : risques à la croisée de l'IA et des menaces nucléaires, biologiques et cybernétiques

Le caractère à double tranchant des systèmes d'IA peut amplifier celui d'autres technologies - c'est ce que l'on appelle la convergence de l'IA. Nous fournissons une expertise politique aux décideurs américains dans trois domaines essentiels de convergence : biologique, nucléaire et cybernétique.

Concours créatif sur la superintelligence

Le concours du meilleur matériel de formation créatif sur la superintelligence, les risques associés, ainsi que sur les répercussions de cette technologie dans notre monde. 5 prix de 10 000 $ chacun.

La lettre des sages sur les menaces existentielles

Les sages, le Future of Life Institute et de nombreuses personnalités éminentes appellent les dirigeants du monde à s'attaquer d'urgence aux dommages et aux risques croissants de la crise du climat, des pandémies, des armes nucléaires et de l'IA non gouvernée.

Mise en œuvre de la loi européenne sur l'IA

Nos principales recommandations consistent à élargir le champ d'application de la loi pour réglementer les systèmes à usage général et elles visent à étendre la définition de la manipulation interdite à tout type de technique de manipulation, ainsi qu'à la manipulation qui cause un préjudice à la société.

Sensibilisation aux armes autonomes

Les applications militaires de l'IA se développent rapidement. Nous élaborons des documents pédagogiques sur la manière dont certaines catégories restreintes d'armes utilisant l'IA peuvent nuire à la sécurité nationale et déstabiliser la civilisation, notamment les armes dans lesquelles la décision de tuer est entièrement déléguée à des algorithmes.

Gouvernance mondiale de l'IA à l'ONU

Notre participation aux travaux des Nations Unies s'étend sur plusieurs années et comprend plusieurs initiatives, y compris la feuille de route pour la coopération numérique et le pacte mondial pour le numérique (GDC).

Future of Life Award

Chaque année, le Future of Life Award est décerné à un ou plusieurs héros méconnus qui ont contribué de manière significative à préserver l'avenir de la vie.

Afficher tous les projets

Bulletin d'informations

Des mises à jour régulières sur les technologies qui façonnent notre monde

Chaque mois, nous donnons à plus de 41 000 abonnés les dernières nouvelles sur la façon dont les technologies émergentes transforment notre monde. Cela comprend un résumé des principaux développements dans nos domaines d'intervention, ainsi que des mises à jour essentielles sur le travail que nous effectuons. Abonnez-vous à notre bulletin d'informations pour être informé de ces points forts à la fin de chaque mois.

Lettre d'information de lFuture of Life Institute : Le Sénat rejette l'interdiction de réglementer l'IA

Plus : les dossiers OpenAI ; une nouvelle vidéo InsideAI qui donne la chair de poule ; et plus encore.

Maggie Munro

3 Juillet, 2025

Future of Life Institute Bulletin d'information : Un grand et beau projet de loi… interdisant les lois étatiques sur l'IA ?!

Plus : Mises à jour sur le code de pratique de la loi européenne sur l'IA ; le consensus de Singapour ; lettre ouverte des dirigeants évangéliques ; et plus encore.

Maggie Munro

31 mai, 2025

Bulletin d'information de lFuture of Life Institute : Où sont les équipes de sécurité ?

Plus : Cours en ligne sur la construction d'un monde positif grâce à l'IA ; nouvelles publications sur l'IA ; notre accélérateur de médias numériques ; et plus encore.

Maggie Munro

1 mai, 2025

Lire les éditions précédentes

Nos contenus

Derniers articles

Les articles les plus récents que nous avons publiés :

Sommes-nous proches d'une explosion du renseignement ?

Les IA se rapprochent de plus en plus d'un seuil critique. Au-delà de ce seuil, les risques sont grands, mais son franchissement n'est pas inéluctable.

21 Mars, 2025

L'impact de l'IA sur l'éducation : Naviguer dans l'avenir imminent

Que faut-il prendre en compte pour construire un avenir sûr mais efficace pour l'IA dans l'éducation, et pour que les enfants soient en sécurité en ligne ?

13 Février, 2025

Contexte et ordre du jour du sommet pour l'action sur l'IA 2025

Le sommet pour l'action sur l'IA se tiendra à Paris du 10 au 11 février 2025. Voici l'ordre du jour et les principaux résultats attendus.

31 janvier, 2025

Une perspective bouddhiste sur l'IA : cultiver la liberté d'attention et la véritable diversité dans un avenir dominé par l'IA

Certains prétendent que la révolution de l'intelligence facilitée par l'IA met l'humanité sur la voie d'un avenir utopique de satisfaction presque sans effort et de choix sans friction. Nous devons nous méfier.

20 janvier, 2025

Papiers

Les documents politiques et de recherche les plus récents que nous avons publiés :

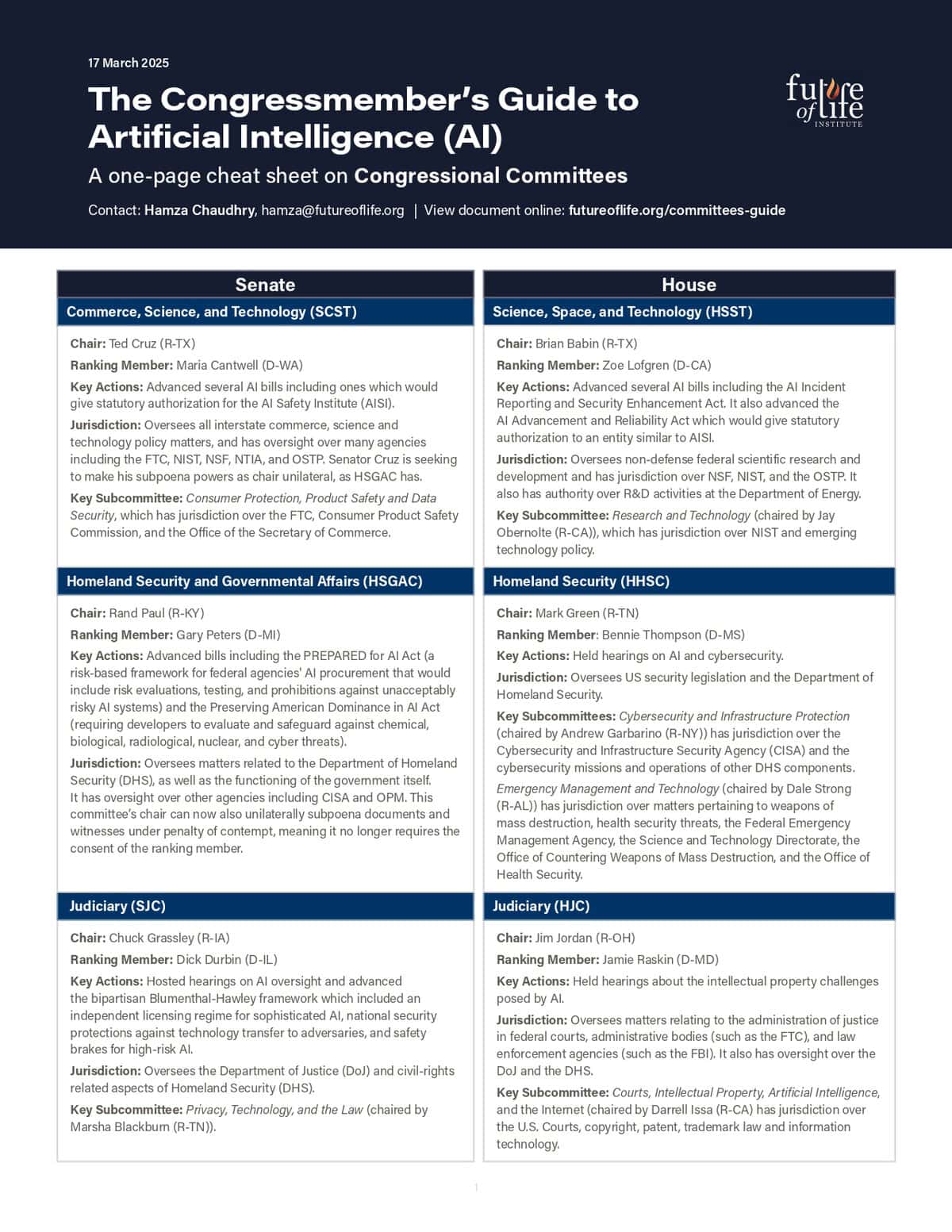

Guide du collaborateur sur la politique en matière d'IA : Commissions du Congrès et législation pertinente

Mars 2025

Recommandations pour le plan d'action américain en matière d'IA

Mars 2025

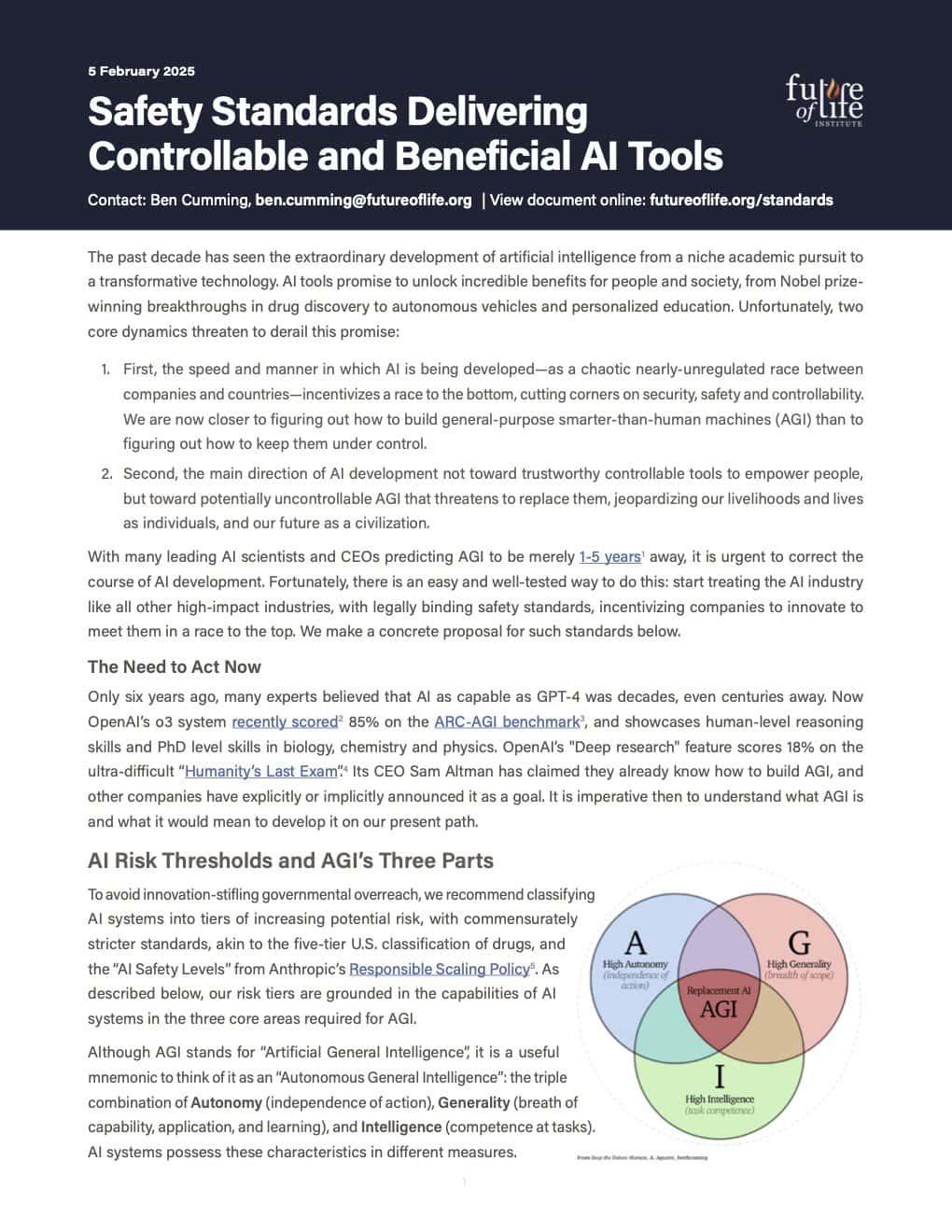

Normes de sécurité pour des outils d'IA contrôlables et bénéfiques

Février 2025

Cadre pour une utilisation responsable de l'IA dans le domaine nucléaire

Février 2025

Voir tous les articles

Future of Life Institute Podcast

Les podcasts les plus récents que nous avons diffusés :

Voir tous les épisodes