Op-ed: On AI, Prescription Drugs, and Managing the Risks of Things We Don’t Understand – Chinese

Contents

专栏文章:人工智能,处方药和管理我们不理解的事物的风险

Click here to see this page in other languages : English ![]()

上个月,麻省理工学院技术评论发表了一篇很好地讨论了“人工智能(AI)核心中黑暗秘密” 的 文章 -那就是“没人真正知道最先进的算法如何操作。”算法系统的不透明性早已受到关注和批评。但是,随着突破“深度学习”导致AI的复杂程度迅速增加,在近几年来这顾虑正在扩大和加深。这些深层次的学习系统使用由人类大脑运作方式启发的深层神经网络 -或者,更准确地说,这些深层次的学习系统运用的是我们目前了解的去模拟人脑的运作方式。

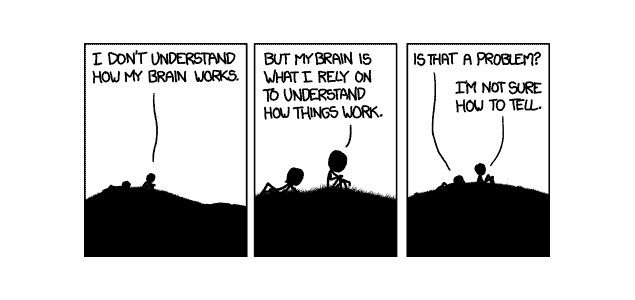

这样的系统可以有效地“自行编程”大部分或绝大部分的程序。由这种系统所产生的代码可以是非常复杂的。它们的复杂性甚至连最初编程系统的人也未必能完全解释为什么它们如此操作:

你不能只凭看一个深层神经网络的内部来了解它怎么运作。网络的推理嵌入在成千上万模拟神经元的行为,排列成几十甚至上百个错综复杂的互联层。在第一层的每个神经元会接收输入,如在图像中像素的强度,然后在输出一个新信号之前执行计算。这些输出被馈送,在一个复杂的网络,到下一层的神经元,依此类推,直到总的输出产生。

此外,由于这样的系统目前无法创造一个易于理解系统推理的“记录”,有可能 没人 能充分解释深层次学习系统的行为。

这一点,可以肯定的说,是一个真实的顾虑。现代AI系统的不透明度,正如我在针对这个问题所写的第一篇文章中写道,是使有效管理与AI相关的公共风险变得困难的主要障碍之一。在我的文章中,我指出了这种系统对监管机构,行业机构和普通公众的不透明度是个问题。如果程序连对系统的创造者也不透明,这个问题的严重性将增大几个数量级。

我们已经看到自动交易系统界讨论相关的问题。这些系统的算法足够的神秘,所以得了“黑箱交易”系统的绰号。算法交易系统之间的相互作用被广泛指责为推动2010年闪电崩盘的祸首。不过,据我所知,没有人认为崩盘的原因是因为设计师不理解涉及闪电崩盘的算法。相反的,那些算法系统之间的相互作用才是令设计师难以建模和预测的。这使得这些风险比那些不被理解的技术所产生的风险更加容易管理。

话虽如此,我不把无知看作为一个真正 难以逾越的障碍,也不认为因为不了解就将不透明AI系统的开发完全“禁止”是一个明智的做法。人类实际上在这几百年,甚至几千年,创建和使用没有人能理解的东西。对我而言,最明显的例子可能来自医药领域。即使没有人能真正理解 为什么 治疗是安全和有效的,但这领域仍研发安全有效的治疗方法。

在18世纪90年代,爱德华·詹纳为了赋予人们对天花病的免疫性而研制出疫苗。当时,没有人知道天花病是由病毒引起的。事实上,人们在当时甚至还没发现病毒。在18世纪,传染性疾病传播的主要理论是由 不良气味的烟雾。半个多世纪后 疾病细菌学说 逐渐获得认可;近一个世纪后才发现了病毒。

如今,甚至有许多医生开的药物所作用的机制只被部分或勉强理解。许多精神病药物符合这一描述。药理学家对三环类抗抑郁药似乎能帮助抑郁症和患有神经性疼痛的患者的原因作出假设。但假设仍然只是,嗯,一个假设。想必深层次学习系统的设计师也能够对系统如何达到当前状态做出假设,即使这些假设可能还不如那些关于三环类抗抑郁药来得灵通。

我们的社会早已得了共识,即使没有人完全了解药物并不意味着任何人都不应该使用这类药物。但我们已设法管理有潜质的新药物所带来的风险,在它们上药店的货架前要求药物通过彻底的测试,并证明是安全的。实际上,除了核技术,医药可能是世界上被监管最严格的技术。

在美国,许多人(尤其是那些在制药行业的人)批评药物在批准使用之前必须经过长期,艰巨和曲折的过程。但是,当药物最终投放市场时,这个过程使我们能够对药物的安全性非常有信心(或者至少觉得是“足够安全”)。而这,反过来,意味着我们可以服用那些我们不太了解作用机制的药物,因为我们知道,任何隐患将极有可能已经在测试过程中暴露出来。

AI能从中吸取什么教训?最明显的是,有必要确保AI系统都经过严格测试后才可以销售给公众,起码如果AI系统不能至少让设计它的人通过“显示其作品”理解其决策过程。我不相信AI系统会有一个美国食品药品监督管理局(FDA)式的超级监管制度。 FDA的模式对这样一个复杂的数字技术即不实际也不有效。但我们很可能看到的是法院和法律制度要求企业将深层次的学习系统通过比典型数字技术前代产品更广泛的测试。

由于这样的测试很可能是漫长的,并需要很多人力才能完成,这种测试的必要性将使较小的公司在AI行业更难获得发展动力,进一步提高像谷歌,亚马逊,Facebook,微软和苹果等巨头的市场力量。也就是说,正如在品牌药品行业中发生的现象一样,AI市场力量将日益集中在少数企业手中的现象并不会是个巧合 。而作为该行业的观察者所知,市场实力集中带有 自己的风险 。这可能是我们若要从不完全理解的科技中受益所付出的代价。

这篇文章最初出现在 法律和AI。

注意:我们的目标在于激发讨论和思想的交流。因此,我们发布那些我们相信能帮助我们激发讨论的专栏文章。专栏文章并不一定代表FLI的意见或观点。

About the Future of Life Institute

The Future of Life Institute (FLI) is a global think tank with a team of 20+ full-time staff operating across the US and Europe. FLI has been working to steer the development of transformative technologies towards benefitting life and away from extreme large-scale risks since its founding in 2014. Find out more about our mission or explore our work.