Kämpfen für eine menschliche Zukunft.

KI wird die Welt verändern.

Helfen Sie uns, dafür zu sorgen, dass wir alle davon profitieren.

Helfen Sie uns, dafür zu sorgen, dass wir alle davon profitieren.

Aktuelle Updates von uns

Darunter: unser KI-Sicherheitsindex für den Winter 2025, das neue KI-Sicherheitsgesetz von New York, die KI-Verordnung des Weißen Hauses, die Ergebnisse unseres Wettbewerbs „Keep the Future Human“ und vieles mehr!

31 Dezember, 2025

Außerdem: Der erste gemeldete Fall von KI-gestützter Spionage; warum Superintelligenz nicht kontrollierbar wäre; Erkenntnisse aus dem WebSummit und vieles mehr.

1 Dezember, 2025

Plus: Letzter Aufruf für Doktorandenstipendien und Kreativwettbewerb; neue kalifornische KI-Gesetze; FLI stellt ein; kann KI wirklich kreativ sein? und mehr.

1 November, 2025

Hören Sie jeden Monat von uns

Schließen Sie sich den über 40.000 anderen Newsletter-Abonnenten an und erhalten Sie monatlich aktuelle Informationen über unsere Arbeit zur Sicherung unserer gemeinsamen Zukunft.

Unsere Mission

Steuerung der transformativen Technologie

zum Nutzen des Lebens und weg von extremen Risiken im großen Maßstab.

zum Nutzen des Lebens und weg von extremen Risiken im großen Maßstab.

Wir glauben, der wichtigste Faktor für die Zukunftsaussichten des Lebens wird die Herangehensweise sein, mit der transformative Technologien entwickelt und eingesetzt werden. Deshalb haben wir es uns zur Aufgabe gemacht, dafür zu sorgen, dass sich diese Aussichten weiter verbessern.

Mehr erfahren

Schwerpunktbereiche

Künstliche Intelligenz

KI kann ein unglaubliches Werkzeug sein, das echte Probleme löst und das menschliche Wohlergehen beschleunigt, oder eine unkontrollierbare Kraft, die die Gesellschaft destabilisiert, die meisten Menschen entmündigt, Terrorismus ermöglicht und uns ersetzt.

Biotechnologie

Fortschritte in der Biotechnologie können die Medizin, die Produktion und die Landwirtschaft revolutionieren, aber ohne angemessene Sicherheitsvorkehrungen erhöhen sie auch das Risiko von künstlich erzeugten Pandemien und neuartigen biologischen Waffen.

Atomwaffen

Die friedliche Nutzung der Nukleartechnologie kann zu einer nachhaltigen Zukunft beitragen, aber Atomwaffen bergen die Gefahr einer Massenkatastrophe, einer Eskalation von Konflikten, eines nuklearen Winters, einer weltweiten Hungersnot und eines Staatszerfalls.

Ausgewählte Videos

Die besten aktuellen Inhalte von uns und unseren Partnern:

Mehr Videos

Ausgewählte Projekte

Informieren Sie sich über einige unserer aktuellen Projekte:

Kürzlich angekündigt

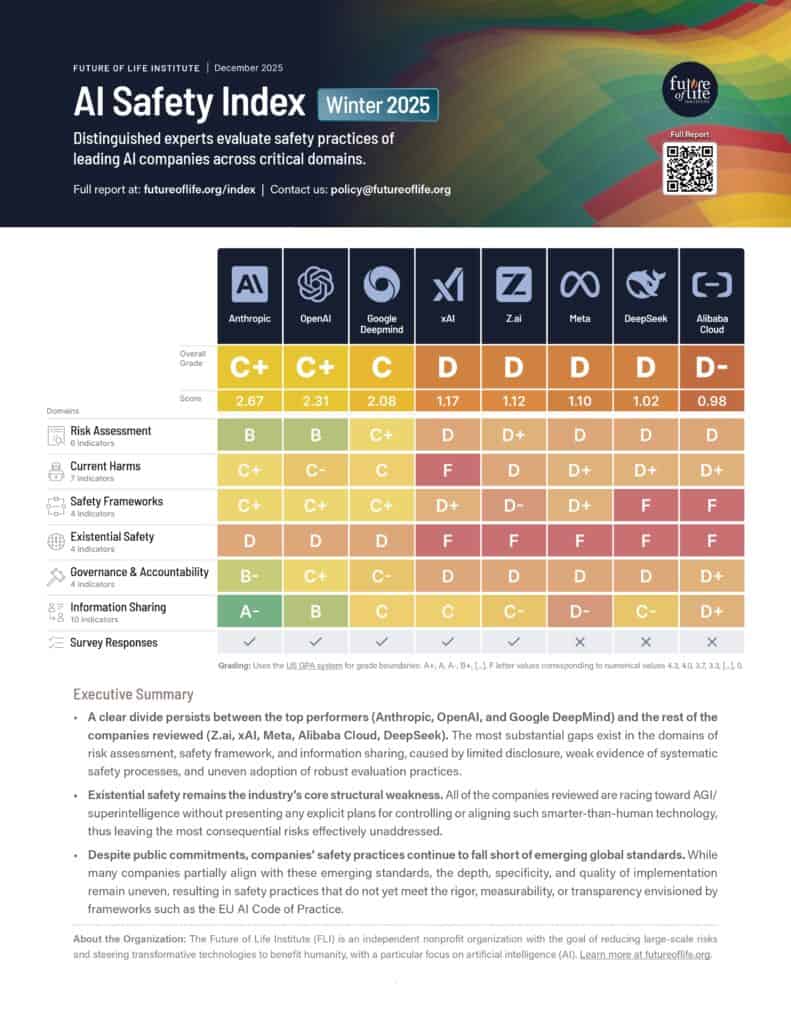

FLI : Ausgabe Winter 2025

Acht KI- und Governance-Experten bewerten die Sicherheitspraktiken führender Allzweck-KI-Unternehmen.

Politik und Forschung

Alle anzeigen

Förderung eines globalen KI-Abkommens

Wir brauchen internationale Koordination, damit die Vorteile der KI weltweit zum Tragen kommen und sich nicht nur auf wenige Orte konzentrieren. Die Risiken fortschrittlicher KI bleiben nicht innerhalb der Landesgrenzen, sondern verbreiten sich weltweit und betreffen alle Menschen. Wir sollten auf einen internationalen Regulierungsrahmen hinarbeiten, der eine Konzentration der Vorteile auf wenige Orte verhindert und die globalen Risiken fortschrittlicher KI mindert.

Empfehlungen für den AI-Aktionsplan der USA

Der Vorschlag des Future of Life Institute für den KI-Aktionsplan von Präsident Trump. Unsere Empfehlungen zielen darauf ab, die Präsidentschaft vor dem Kontrollverlust über KI zu schützen, die Entwicklung von KI-Systemen frei von ideologischen oder sozialen Agenden zu fördern, amerikanische Arbeitnehmer vor Arbeitsplatzverlust und Ersatz zu schützen und vieles mehr.

KI-Konvergenz: Risiken am Schnittpunkt von KI zu nuklearen, biologischen und Cyber-Bedrohungen

Das Gefahrenpotenzial von KI-Systemen kann die Gefahrenpotenziale anderer Technologien verstärken – dies wird als KI-Konvergenz bezeichnet. Wir bieten politischen Entscheidungsträgern in den Vereinigten Staaten politische Expertise in drei wichtigen Konvergenzbereichen: Bio-, Nuklear- und Cybertechnologien.

Zukunftsvisionen

Alle anzeigen

Die Rolle von KI bei der Umverteilung von Macht

Hochentwickelte KI-Systeme werden die Wirtschaft und die Machtstrukturen in der Gesellschaft umgestalten. Sie bieten ein enormes Potenzial für Fortschritt und Innovation, bergen aber auch die Gefahr konzentrierter Kontrolle, nie dagewesener Ungleichheit und Entmündigung. Um sicherzustellen, dass KI dem Gemeinwohl dient, müssen wir widerstandsfähige Institutionen, wettbewerbsfähige Märkte und Systeme aufbauen, die die Vorteile breit verteilen.

Positive Zukunftsvisionen mit Technologie

Storytelling hat einen signifikanten Einfluss auf die Überzeugungen und Vorstellungen der Menschen über die mögliche Zukunft der Menschheit mit Technologie. Zwar warnen viele Erzählungen vor Dystopien, aber positive Zukunftsvisionen sind Mangelware. Wir versuchen Anreize für die Schaffung plausibler, erstrebenswerter und hoffnungsvoller Visionen einer Zukunft schaffen, die wir anstreben wollen.

Religiöse Perspektiven auf eine positive KI-Zukunft

Der Großteil der Weltbevölkerung gehört einer Religion an. Dennoch sind die Perspektiven dieser Religionen in den strategischen Diskussionen über künstliche Intelligenz weitgehend abwesend. Diese Initiative zielt darauf ab, religiöse Gruppen dabei zu unterstützen, ihre glaubensspezifischen Bedenken und Hoffnungen für eine Welt mit KI zu äußern und mit ihnen zusammenzuarbeiten, um Schäden abzuwenden und Vorteile zu realisieren.

Kommunikation

Alle anzeigen

Kontrolle Umkehrung

Warum die superintelligenten KI-Agenten, die wir erschaffen wollen, Macht absorbieren, statt sie zu gewähren | Die neueste Studie von Anthony Aguirre.

Digital Media Accelerator

Der Digital Media Accelerator unterstützt digitale Inhalte von Urhebern, die das Bewusstsein und das Verständnis für aktuelle KI-Entwicklungen und -Themen fördern.

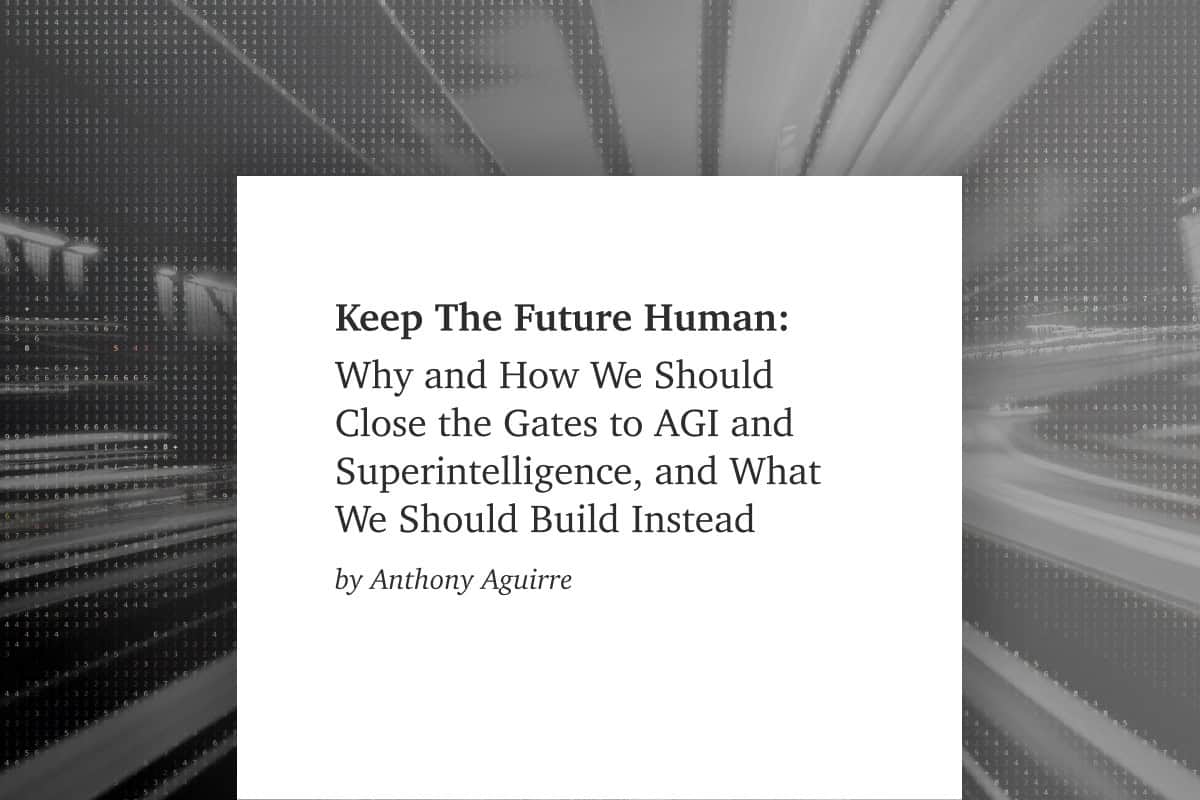

Die Zukunft menschlich gestalten

Warum und wie wir die Tore zu AGI und Superintelligenz schließen sollten, und was wir stattdessen bauen sollten | Ein neuer Essay von Anthony Aguirre, Geschäftsführer des FLI.

Vergabe von Förderung

Alle anzeigen

KI-Community für Existenzielle Sicherheit

Eine Gemeinschaft, die sich dafür einsetzt, dass KI sicher entwickelt wird, und der sowohl Lehrkräfte als auch KI-Forscher angehören. Die Mitglieder sind eingeladen, an Sitzungen teilzunehmen, sich an einer Online-Community zu beteiligen und Reiseunterstützung zu beantragen.

Stipendien

Seit 2021 bieten wir Doktoranden- und Postdoktorandenstipendien für technische KI-Existenzsicherheit an. Im Jahr 2024 haben wir ein Doktorandenstipendium zum Thema "US-China AI Governance" eingerichtet.

RFPs, Wettbewerbe und Kooperationen

Aufforderungen zur Einreichung von Vorschlägen (RFP), öffentliche Wettbewerbe und Kooperationszuschüsse zur direkten Unterstützung von internen Projekten und Initiativen FLI .

Newsletter

Regelmäßige Updates zu den Technologien, die unsere Welt verändern

Jeden Monat informieren wir mehr als 40 000 Abonnenten über die neuesten Entwicklungen im Bereich der neuen Technologien, die unsere Welt verändern. Er enthält eine Zusammenfassung der wichtigsten Entwicklungen in unseren Schwerpunktbereichen und wichtige Updates zu unserer Arbeit.

Abonnieren Sie unseren Newsletter, um diese Highlights am Ende eines jeden Monats zu erhalten.

Neuere Ausgaben

Darunter: unser KI-Sicherheitsindex für den Winter 2025, das neue KI-Sicherheitsgesetz von New York, die KI-Verordnung des Weißen Hauses, die Ergebnisse unseres Wettbewerbs „Keep the Future Human“ und vieles mehr!

31 Dezember, 2025

Außerdem: Der erste gemeldete Fall von KI-gestützter Spionage; warum Superintelligenz nicht kontrollierbar wäre; Erkenntnisse aus dem WebSummit und vieles mehr.

1 Dezember, 2025

Plus: Letzter Aufruf für Doktorandenstipendien und Kreativwettbewerb; neue kalifornische KI-Gesetze; FLI stellt ein; kann KI wirklich kreativ sein? und mehr.

1 November, 2025

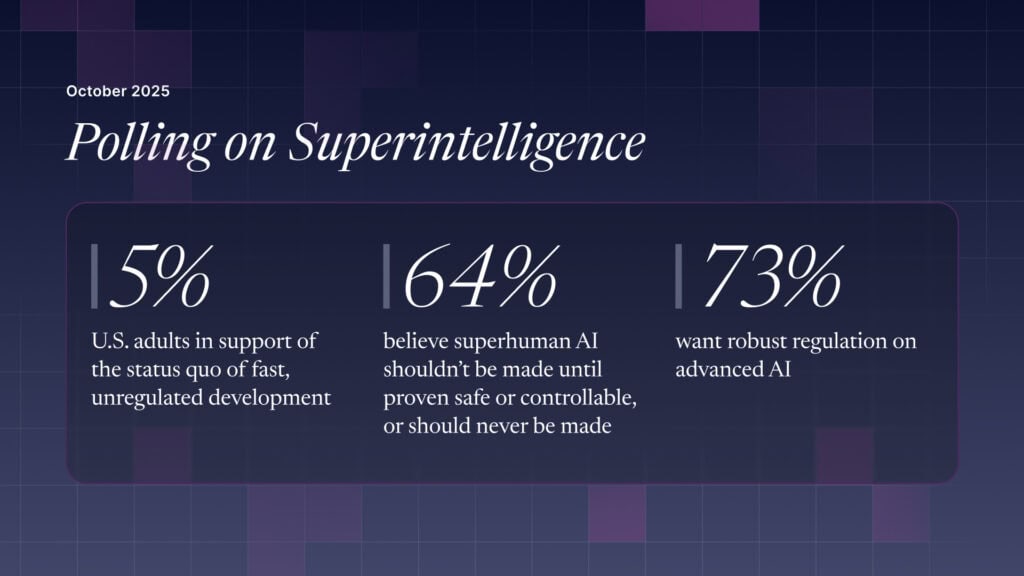

Plus: Bewerbungen für Stipendien sind möglich; globaler Aufruf für rote Linien bei der KI; neue Umfragen zeigen, dass 90 % der Befragten KI-Regeln befürworten; Anmeldung für unseren 100.000-Dollar-Kreativwettbewerb und mehr.

1 Oktober, 2025

Alle anzeigen

Neuester Inhalt

Die neuesten Inhalte, die wir veröffentlicht haben:

Ausgewählter Inhalt

Wir dürfen KI nicht entwickeln, um Menschen zu ersetzen.

Ein neuer Essay von Anthony Aguirre, Geschäftsführer des Future of Life Institute

Die Menschheit steht kurz davor, eine künstliche allgemeine Intelligenz zu entwickeln, die unsere eigene übertrifft. Es ist an der Zeit, die Tore zu AGI und Superintelligenz zu schließen... bevor wir die Kontrolle über unsere Zukunft verlieren.

Lesen Sie den Aufsatz ->Beiträge

Die US-Öffentlichkeit will eine Regulierung (oder ein Verbot) von KI auf Expertenebene und übermenschlicher KI

Drei Viertel der Erwachsenen in den USA wünschen sich strenge Vorschriften für die Entwicklung von KI und bevorzugen eine Aufsicht ähnlich wie bei Arzneimitteln anstelle einer "Selbstregulierung" der Industrie.

19 Oktober, 2025

Michael Kleinman reagiert auf die bahnbrechende Gesetzgebung zur KI-Sicherheit

Das FLI feiert einen Meilenstein für die KI-Sicherheitsbewegung und unterstreicht ihre wachsende Dynamik

3 Oktober, 2025

Stehen wir kurz vor einer Intelligenzexplosion?

Die KI nähert sich immer mehr einer kritischen Schwelle. Jenseits dieser Schwelle lauern große Risiken - aber sie zu überschreiten ist nicht unvermeidlich.

21 März, 2025

Die Auswirkungen von KI im Bildungswesen: Navigieren in der nahen Zukunft

Was muss beachtet werden, um eine sichere, aber effektive Zukunft für KI in der Bildung und für die Sicherheit von Kindern im Internet zu schaffen?

13 Februar, 2025

Alle anzeigen

Podcasts

Verfügbar auf allen Podcast-Plattformen:

-

Neueste

Klima-Interview mit Seth Baum

23 Januar, 2026

nukleares_Interview_David_Wright

23 Januar, 2026

Erdbeben als existenzielles Risiko?

23 Januar, 2026

Das nukleare Risiko im 21. Jahrhundert

23 Januar, 2026

Alle anzeigen

Forschungsapiere

Benutze deine Stimme

Beschütze das Menschliche

Große Technologieunternehmen sind dabei, immer leistungsfähigere, unkontrollierbare KI-Systeme zu entwickeln, die menschliche Arbeitskraft ersetzen sollen. Sie haben die Möglichkeit, etwas dagegen zu tun.

Werden Sie heute aktiv, um unsere Zukunft zu schützen:

Maßnahmen ergreifen ->

Unser Team

Ein Team, das sich für die Zukunft des Lebens einsetzt.

Unser Team verfügt über ein breites Spektrum an Fachwissen und Erfahrung in Wissenschaft, Regierungstätigkeit und freier Wirtschaft. Als solches bieten wir Expertise in zahlreichen Disziplinen, vom maschinellem Lernen bis hin zur Medizin.

Treffen Sie unser Team

Unsere Geschichte

Seit 2014 arbeiten wir daran, die Zukunft der Menschheit zu sichern.

Erfahren Sie mehr über die Arbeit und die Erfolge des FLIseit seiner Gründung, einschließlich historischer Konferenzen, Zuschussprogramme und offener Briefe, die die Entwicklung der Technologie geprägt haben.