How AI Handles Uncertainty: An Interview With Brian Ziebart Russian

Contents

Как ИИ справляется с неопределённостью. Интервью с Брайаном Зибартом

Click here to see this page in other languages: English![]()

Обучая детекторы изображений, разработчики ИИ не могут воспроизвести реальный мир. Они учат систему распознавать, сохраняя в нее обучающие данные, такие как фотографии, картинки, сгенерированные компьютером, настоящие и смоделированные видео, но эта тренировочная среда никогда не сможет отразить беспорядок физического мира.

В машинном обучении детекторы изображений учатся определять объекты, рисуя ограничивающие рамки вокруг них и давая им обозначения. И хотя тренировочное распознавание успешно в простой обстановке, далее оно быстро усложняется.

Легко распознать человека слева, но как вы нарисуете ограничивающие рамки вокруг человека справа? Вы включите только видимую часть тела или скрытые торс и ноги тоже? Эти различия могут показаться незначительными, но они указывают на коренную проблему в распознавании объектов: редко способ определения объекта единственный.

Как показывает вторая картинка, реальный объект редко ясно отделим, и правильный ответ обычно неоднозначен. Однако, когда системы машинного обучения используют обучающие данные, чтобы разработать своё понимание мира, они не в состоянии осознать это. Вместо того, чтобы признать неопределённость и двусмысленность, эти системы часто уверенно подходят к новым ситуациям так же, как к обучающим данным, что может подвергнуть риску и системы, и людей.

Брайан Зибарт, профессор компьютерных наук в Иллинойском университете в Чикаго, руководит исследованием, направленным на совершенствование способностей систем ИИ в работе среди неотъемлемой неопределённости вокруг них. Реальный мир беспорядочен и непредсказуем, и поэтому если мы хотим доверять нашим системам ИИ, они должны быть в состоянии успешно справиться.

Чрезмерная самоуверенность в системах машинного обучения.

Системы машинного обучения неизбежно будут сталкиваться с реальными ситуациями, к которым их не готовили тренировочные данные. Но, как объясняет Зибарт, современные статистические модели «склонны предполагать, что данные, которые они увидят в будущем, будут схожи с теми, которые они видели в прошлом».

В результате, эти системы слишком уверенны в том, что они знают, что делать, даже когда они сталкиваются с новыми задачами, которые совершенно не похожи на те, которые они когда-либо видели. Системы машинного обучения ошибочно предполагают, что их обучение подготовило их ко всему, и полученная в результате самоуверенность может привести к опасным последствиям.

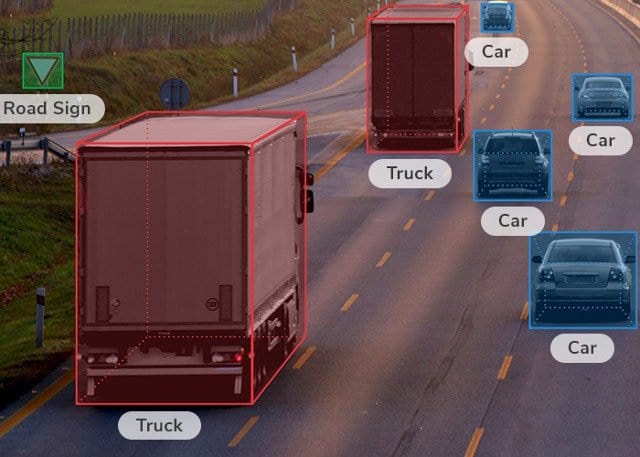

Рассмотрим распознавание изображений для беспилотного автомобиля. Машина может тренировать распознавание объектов используя данные с приборной панели другой машины, отслеживая поле зрения и рисуя ограничивающие рамки вокруг определённых объектов, как на следующей картинке:

В случаях с такими ясными изображениями как это, детекторы изображений успешно справляются с задачей. Но реальный мир не всегда так прост. Если исследователи обучают детектор изображений на ясных, хорошо освещённых изображениях в лаборатории, он может распознать объекты на картинках примерно в 80% случаев. Но когда приходится перемещаться по дорогам в дождливую ночь, этот показатель может упасть до 40%.

“Если вы соберете все свои данные в течение дня, а затем попытаетесь задействовать систему ночью, то, так как она была обучена распознавать изображения в светлое время суток, она просто-напросто не будет хорошо работать, когда вы запустите систему при этих новых условиях”, – объясняет Зибарт.

Более того, система машинного обучения может не обнаружить проблему: поскольку система предполагает, что её обучение охватывало всё, она останется уверенной в своих решениях и продолжит “делать сильные прогнозы, которые просто неверны”, – добавляет Зибарт.

Люди, наоборот, склонны осознавать, когда предыдущий опыт не помогает в новых условиях. Если водитель замечает неизвестный объект впереди на дороге, он не просто проедет мимо него. Вместо этого он может замедлиться, обратить внимание на то, как другие автомобили реагируют на объект, и рассмотреть возможность поворота, если это безопасно. Когда мы чувствуем неуверенность в отношении среды, окружающей нас, мы проявляем осторожность, чтобы избежать опасных ошибок.

Зибарт хотел бы, чтобы системы ИИ предусматривали аналогичные уровни осторожности для неопределенных ситуаций. Вместо того, чтобы уверенно делать ошибки, система должна признать неопределенность и задавать вопросы, чтобы собрать больше информации так же, как не сомневающийся человек.

Состязательный подход

Обучение и практика никогда не смогут подготовить системы ИИ к каждой возможной ситуации, но исследователи могут сделать свои методы обучения более надежными. Зибарт утверждает, что обучение систем более запутанными данными в лаборатории может обучить их лучше распознавать и устранять неопределенность.

Удобно, что люди могут предоставить эти беспорядочные, реальные данные. Нанимая группу комментаторов для просмотра изображений и рисования ограничивающих рамок вокруг определенных объектов – автомобилей, людей, собак, деревьев и т.д. – исследователи могут “встроить в классификатор некоторое представление о том, как выглядят “нормальные ” данные”, – объясняет Зибарт.

“Если вы попросите десять разных людей нарисовать эти ограничительные рамки, вы, вероятно, получите десять разных ограничительных рамок”, – говорит он. “Неотъемлем факт двусмысленности в том, что люди считают истиной для этих вещей.”

Возвращаясь к изображению выше человека в машине, комментаторы могут дать десять различных ограничивающих рамок, которые охватывают разные части видимых и скрытых частей тела человека. Подавая системам машинного обучения эти запутанные и противоречивые данные, Зибарт готовит их к неоднозначности.

“Мы синтезируем больше помех в наборе данных в процессе тренировок, – объясняет Зибарт. Они отражают беспорядок реального мира и обучают системы быть осторожными при прогнозировании в новых условиях. Осторожные и неуверенные, системы ИИ будут искать дополнительную информацию и научатся ориентироваться в запутанных ситуациях, с которыми они сталкиваются.

Конечно, автомобили на автопилоте не должны задавать вопросы. Например, если детектор автомобиля обнаруживает посторонний объект впереди, у него не будет времени просить людей о помощи. Но если он обучен распознавать неопределенность и действовать осторожно, он может замедлиться, обнаружить, что делают другие автомобили, и безопасно перемещаться вблизи объекта.

Составные элементы для машин будущего

До сих пор исследования Зибарта остаются в тренировочных вариантах. Он даёт системам беспорядочные, разнообразные данные и обучает их выделять ограничительные рамки, которые по крайней мере на 70% перекрываются ограничивающими рамками людей. И его работа уже дала впечатляющие результаты. Например, в задаче обнаружения объектов ImageNet, исследованной в сотрудничестве с Сима Бэпур (Университет Иллинойса в Чикаго) и Крис Китани (Университет Карнеги-Меллона), состязательный подход Зибарта “повышает производительность более чем на 16% по сравнению с наилучшим методом увеличения данных”. Обученные работать в условиях неопределенности, эти системы более эффективно справляются с новыми данными, к которым обучение их явно не подготовило.

Но в то время, как Зибарт тренирует относительно узконаправленные системы ИИ, он считает, что это исследование может масштабироваться до более продвинутых систем, таких как автомобили на автопилоте и системы общественного транспорта.

“Я рассматриваю это как своего рода фундаментальную проблему – то, как мы разрабатываем эти системы”, – говорит он. “Мы пытались создать лучшие составные элементы, на которых можно было бы сделать машинное обучение – это лучшие и важнейшие принципы, которые сделают его более надёжным.”

Эта статья является частью серии института Будущее жизни, созданной на гранты на исследования безопасности искусственного интеллекта, которые финансировались за счет щедрых пожертвований Илона Маска и проекта “Открытая Филантропия”.

Статья переведена Рукиной Юлией

About the Future of Life Institute

The Future of Life Institute (FLI) is a global think tank with a team of 20+ full-time staff operating across the US and Europe. FLI has been working to steer the development of transformative technologies towards benefitting life and away from extreme large-scale risks since its founding in 2014. Find out more about our mission or explore our work.