Lutter pour un avenir humain.

L'IA est sur le point de refaire le monde.

Aidez-nous à faire en sorte qu'elle profite à chacun d'entre nous.

Aidez-nous à faire en sorte qu'elle profite à chacun d'entre nous.

Dernières mises à jour

Au sommaire : notre indice de sécurité IA pour l'hiver 2025 ; la nouvelle loi sur la sécurité IA de New York ; le décret présidentiel américain sur l'IA ; les résultats de notre concours « Keep the Future Human » ; et bien plus encore !

31 Décembre, 2025

De plus : le premier cas signalé d'espionnage rendu possible par l'IA ; pourquoi la superintelligence ne serait pas contrôlable ; les enseignements tirés du WebSummit ; et plus encore.

1 Décembre, 2025

Plus : Dernier appel à candidatures pour les bourses de doctorat et le concours de création ; nouvelles lois californiennes sur l'IA ; FLI recrute ; l'IA peut-elle vraiment être créative ? et plus encore.

1 novembre, 2025

Des nouvelles de nous tous les mois

Rejoignez plus de 40 000 autres abonnés à la lettre d'information pour recevoir des mises à jour mensuelles sur le travail que nous accomplissons pour préserver notre avenir commun.

Notre mission

Orienter la technologie transformatrice

vers l'amélioration de la vie et l'éloigner des risques extrêmes à grande échelle.

vers l'amélioration de la vie et l'éloigner des risques extrêmes à grande échelle.

Nous pensons que la manière dont une technologie puissante est développée et utilisée sera le facteur le plus important pour déterminer les perspectives d'avenir de la vie. C'est pourquoi nous nous sommes donnés pour mission de veiller à ce que la technologie continue d'améliorer ces perspectives.

En savoir plus

Domaines d'intervention

Intelligence artificielle

L'IA peut être un outil incroyable qui résout des problèmes réels et accélère l'épanouissement humain, ou une force incontrôlable qui déstabilise la société, prive la plupart des gens de leurs moyens d'action, favorise le terrorisme et nous remplace.

Biotechnologie

Les progrès de la biotechnologie peuvent révolutionner la médecine, la fabrication et l'agriculture, mais en l'absence de garanties adéquates, ils augmentent également le risque de pandémies artificielles et d'armes biologiques nouvelles.

Armes nucléaires

L'utilisation pacifique de la technologie nucléaire peut contribuer à un avenir durable, mais les armes nucléaires risquent de provoquer des catastrophes massives, une escalade des conflits, un éventuel hiver nucléaire, une famine mondiale et l'effondrement d'un État.

Vidéos à l'affiche

Le meilleur contenu récent de notre part et de celle de nos partenaires :

Plus de vidéos

Projets

Découvrez quelques-uns de nos projets actuels :

Récemment annoncé

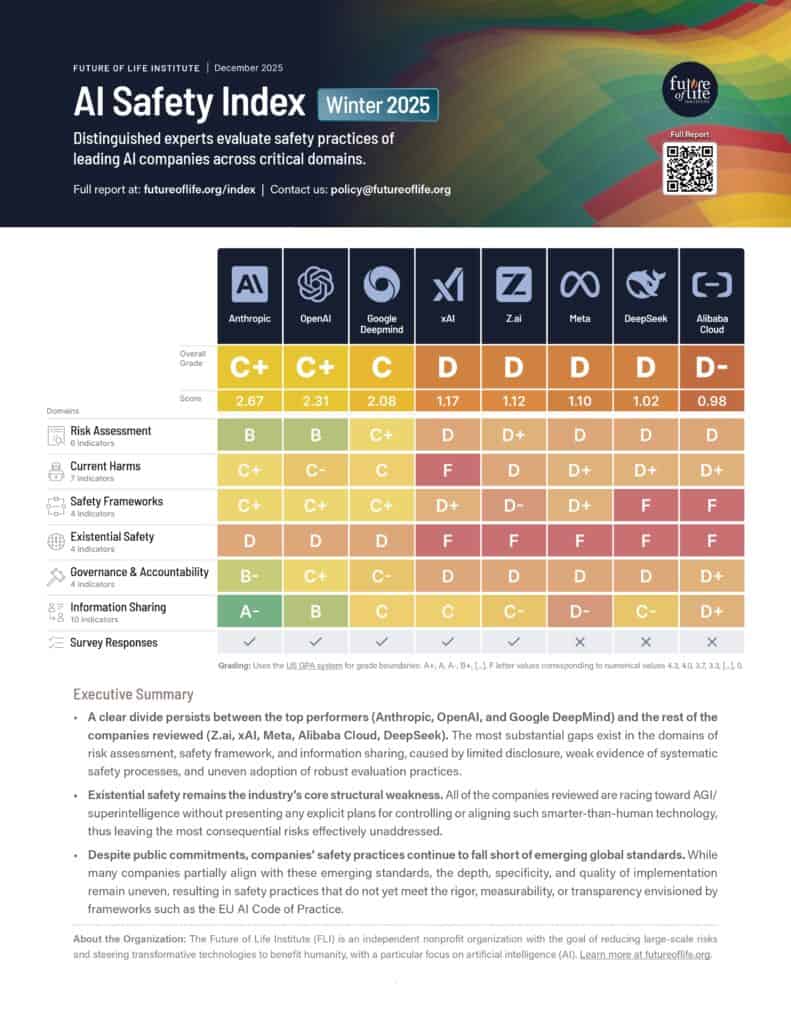

Indice FLI Safety : Édition hiver 2025

Huit experts en IA et en gouvernance évaluent les pratiques de sécurité des principales entreprises d'IA à usage général.

Politique et recherche

Voir tous

Promouvoir un accord mondial sur l'IA

Nous avons besoin d'une coordination internationale afin que les avantages de l'IA profitent à l'ensemble de la planète, et ne se concentrent pas uniquement dans quelques endroits. Les risques liés à l'IA avancée ne resteront pas confinés à l'intérieur des frontières, mais se propageront à l'échelle mondiale et toucheront tout le monde. Nous devons œuvrer à la mise en place d'un cadre de gouvernance international qui empêche la concentration des avantages dans quelques endroits et atténue les risques mondiaux liés à l'IA avancée.

Recommandations pour le plan d'action américain en matière d'IA

La proposition du Future of Life Institute pour le plan d'action du président Trump en matière d'IA. Nos recommandations visent à protéger la présidence contre la perte de contrôle de l'IA, à promouvoir le développement de systèmes d'IA exempts d'agendas idéologiques ou sociaux, à protéger les travailleurs américains contre la perte et le remplacement d'emplois, et plus encore.

Convergence de l'IA : risques à la croisée de l'IA et des menaces nucléaires, biologiques et cybernétiques

Le caractère à double tranchant des systèmes d'IA peut amplifier celui d'autres technologies - c'est ce que l'on appelle la convergence de l'IA. Nous fournissons une expertise politique aux décideurs américains dans trois domaines essentiels de convergence : biologique, nucléaire et cybernétique.

Avenirs

Voir tous

Le rôle de l'IA dans la transformation de la distribution du pouvoir

Les systèmes d'IA avancés sont en passe de remodeler l'économie et les rapports de pouvoir. Bien qu'ils présentent un immense potentiel de progrès et d'innovation, ils comportent aussi le risque d’une concentration extrême du pouvoir, d’inégalités inédites et de perte de contrôle. Pour que l'IA serve le bien commun, il est crucial de mettre en place des institutions résilientes, des marchés concurrentiels, ainsi que des mécanismes de redistribution robustes.

Penser des avenirs positifs où la technologie a sa place

Les récits influencent profondément nos représentations des avenirs potentiels de l'humanité avec la technologie. S'il existe bien des fictions dystopiques, les visions d'un avenir désirable se font rares. Nous cherchons à encourager la création de visions plausibles, ambitieuses et pleines d'espoir d'un avenir que nous voulons atteindre.

Les perspectives des religions traditionnelles sur des avenirs positifs avec l'IA

La majorité de la population mondiale pratique une religion traditionnelle. Pourtant, les perspectives religieuses sont généralement absentes des discussions stratégiques sur l'IA. Cette initiative vise à aider les groupes religieux à exprimer, selon leur foi, leurs préoccupations et leurs espoirs pour un monde avec l’IA, et à collaborer avec eux pour en éviter les dérives et en réaliser les promesses.

Communications

Voir tous

Inversion de contrôle

Pourquoi les agents d'IA superintelligents que nous nous efforçons de créer absorberaient le pouvoir, au lieu de l'octroyer ?

Accélérateur de médias numériques

L'accélérateur de médias numériques soutient le contenu numérique de créateurs qui sensibilisent aux développements et aux problèmes actuels de l'IA et les font mieux comprendre.

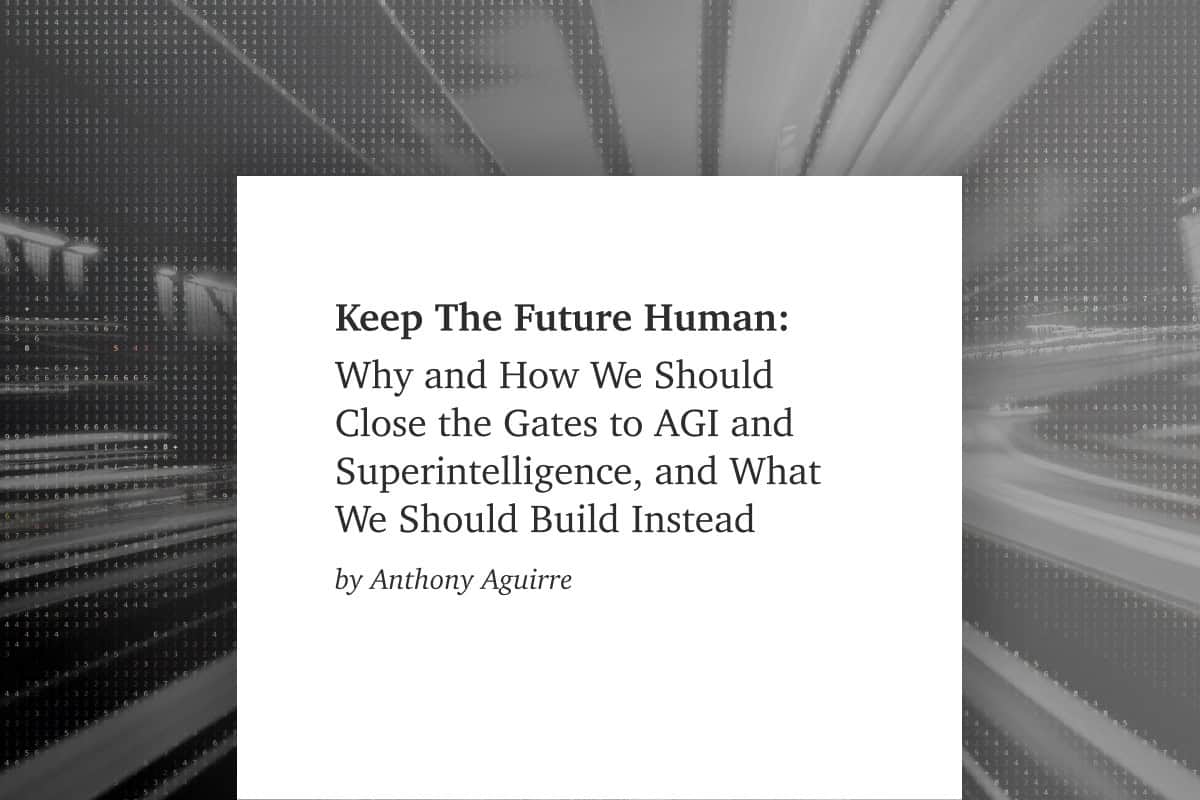

Garder l'avenir humain

Pourquoi et comment nous devrions fermer les portes de l'AGI et de la superintelligence, et ce que nous devrions construire à la place ? Un nouvel essai d'Anthony Aguirre, directeur exécutif de FLI.

Octroi de subventions

Voir tous

Communauté de la sécurité existentielle de l'IA

Une communauté dédiée à la sécurité du développement de l'IA, comprenant à la fois des professeurs et des chercheurs en IA. Les membres sont invités à assister aux réunions, à participer à une communauté en ligne et à demander une aide financière pour leurs déplacements.

Bourses d'études

Depuis 2021, nous proposons des bourses de doctorat et de postdoctorat en sécurité existentielle de l'IA technique. En 2024, nous avons lancé une bourse de doctorat sur la gouvernance de l'IA entre les États-Unis et la Chine.

Appels d'offres, concours et collaborations

Demandes de propositions (RFP), concours publics et subventions de collaboration en soutien direct aux projets et initiatives internes de FLI .

Bulletin d'information

Des mises à jour régulières sur les technologies qui façonnent notre monde

Chaque mois, nous apportons à plus de 40 000 abonnés les dernières nouvelles sur la façon dont les technologies émergentes transforment notre monde. Il comprend un résumé des principaux développements dans nos domaines d'intérêt et des mises à jour essentielles sur le travail que nous effectuons.

Abonnez-vous à notre lettre d'information pour recevoir ces points forts à la fin de chaque mois.

Éditions récentes

Au sommaire : notre indice de sécurité IA pour l'hiver 2025 ; la nouvelle loi sur la sécurité IA de New York ; le décret présidentiel américain sur l'IA ; les résultats de notre concours « Keep the Future Human » ; et bien plus encore !

31 Décembre, 2025

De plus : le premier cas signalé d'espionnage rendu possible par l'IA ; pourquoi la superintelligence ne serait pas contrôlable ; les enseignements tirés du WebSummit ; et plus encore.

1 Décembre, 2025

Plus : Dernier appel à candidatures pour les bourses de doctorat et le concours de création ; nouvelles lois californiennes sur l'IA ; FLI recrute ; l'IA peut-elle vraiment être créative ? et plus encore.

1 novembre, 2025

Plus : Ouverture des candidatures pour les bourses ; appel mondial pour des lignes rouges en matière d'IA ; un nouveau sondage révèle que 90 % des personnes interrogées sont favorables à des règles en matière d'IA ; inscription à notre concours créatif doté de 100 000 dollars ; et plus encore.

1 octobre, 2025

Voir tous

Dernier contenu

Le contenu le plus récent que nous avons publié :

Contenu à la une

Nous ne devons pas construire l'IA pour remplacer les humains.

Un nouvel essai d'Anthony Aguirre, directeur exécutif du Future of Life Institute

L'humanité est sur le point de développer une intelligence artificielle générale qui la dépasse. Il est temps de fermer les portes de l'AGI et de la superintelligence... avant de perdre le contrôle de notre avenir.

Lire l'essai ->Articles

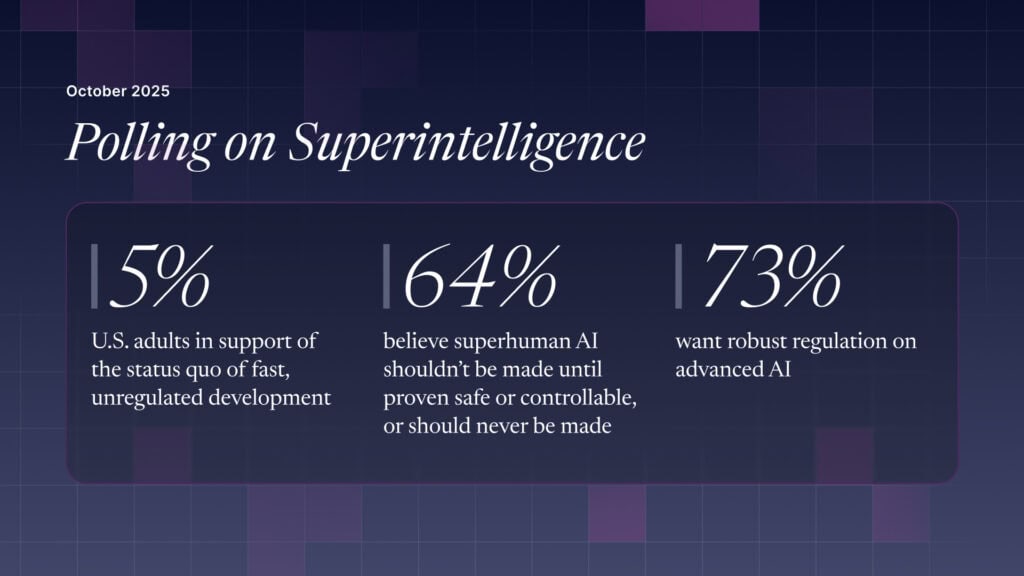

Le public américain souhaite une réglementation (ou une interdiction) de l'IA de niveau expert et surhumain

Les trois quarts des adultes américains souhaitent une réglementation stricte du développement de l'IA, préférant un contrôle similaire à celui des produits pharmaceutiques plutôt qu'une "autorégulation" de l'industrie.

19 octobre, 2025

Michael Kleinman réagit à l'avancée de la législation sur la sécurité de l'IA

FLI célèbre un moment historique pour le mouvement en faveur de la sécurité de l'IA et met en lumière sa dynamique croissante.

3 octobre, 2025

Sommes-nous proches d'une explosion du renseignement ?

Les IA se rapprochent de plus en plus d'un seuil critique. Au-delà de ce seuil, les risques sont grands, mais son franchissement n'est pas inéluctable.

21 Mars, 2025

L'impact de l'IA sur l'éducation : Naviguer dans l'avenir imminent

Que faut-il prendre en compte pour construire un avenir sûr mais efficace pour l'IA dans l'éducation, et pour que les enfants soient en sécurité en ligne ?

13 Février, 2025

Voir tous

Podcasts

Disponible sur toutes les plateformes de podcast :

-

Dernières nouvelles

Comment reconstruire le contrat social après l'AGI (avec Deric Cheng)

27 janvier, 2026

Papiers

Utilisez votre voix

Protégez l'humain.

Les géants de la tech s'affrontent pour développer des systèmes d'intelligence artificielle de plus en plus puissants et incontrôlables, conçus pour remplacer les humains. Vous avez le pouvoir d'agir.

Agissez dès maintenant pour protéger notre avenir :

Agir ->

Nos collaborateurs

Une équipe engagée pour l'avenir de la vie.

Notre personnel se compose de nombreux experts qui ont travaillé dans le monde universitaire, pour le gouvernement et dans l'industrie. Leur expérience va de l'apprentissage automatique à la médecine, en passant par tous les domaines intermédiaires.

Rencontrez notre équipe

Notre histoire

Depuis 2014, nous nous efforçons de préserver l'avenir de l'humanité.

Découvrez le travail et les réalisations de la FLIdepuis sa création, notamment les conférences historiques, les programmes de subventions et les lettres ouvertes qui ont influencé le cours de la technologie.