Travail sur la politique

Introduction

Améliorer la gouvernance des technologies de transformation

L'équipe politique du FLI s'efforce d'améliorer la gouvernance nationale et internationale de l'IA. Le FLI a investi beaucoup de ressources à cette fin.

En 2017, nous avons créé les Principes d'Asilomar AI, qui ont eu une grande influence. Il s'agit d'un ensemble de principes de gouvernance signés par des milliers d'esprits éminents de la recherche et de l'industrie de l'IA. Plus récemment, notre lettre ouverte de 2023 a suscité un débat mondial sur la place légitime de l'IA dans nos sociétés. Le FLI a témoigné devant le congrès des États-Unis, le Parlement européen et d'autres juridictions importantes.

Dans le domaine civil, nous conseillons les décideurs politiques sur la meilleure façon de gérer les systèmes d'IA avancés. Dans le domaine militaire, nous plaidons aux Nations Unies en faveur d'un traité sur les armes autonomes et nous informons les décideurs politiques des risques liés à l'intégration de systèmes d'IA dans le lancement d'armes nucléaires.

Projets politiques

Lutter contre les "deepfakes

Sommets sur la sécurité de l'IA

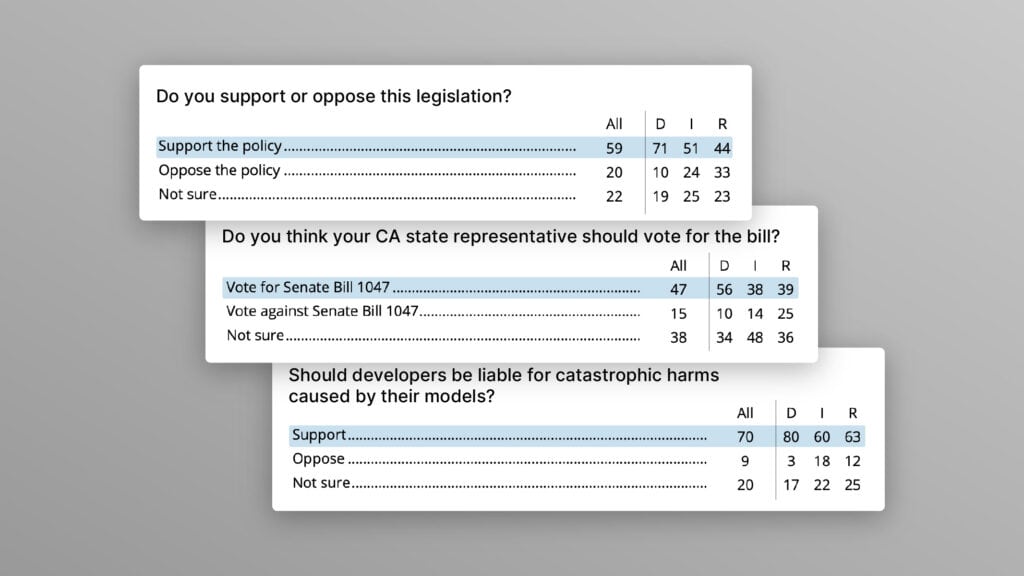

Élaboration de règles possibles en matière d'IA pour les États-Unis

S'engager en faveur du décret sur l'IA

Convergence de l'IA : risques à la croisée de l'IA et des menaces nucléaires, biologiques et cybernétiques

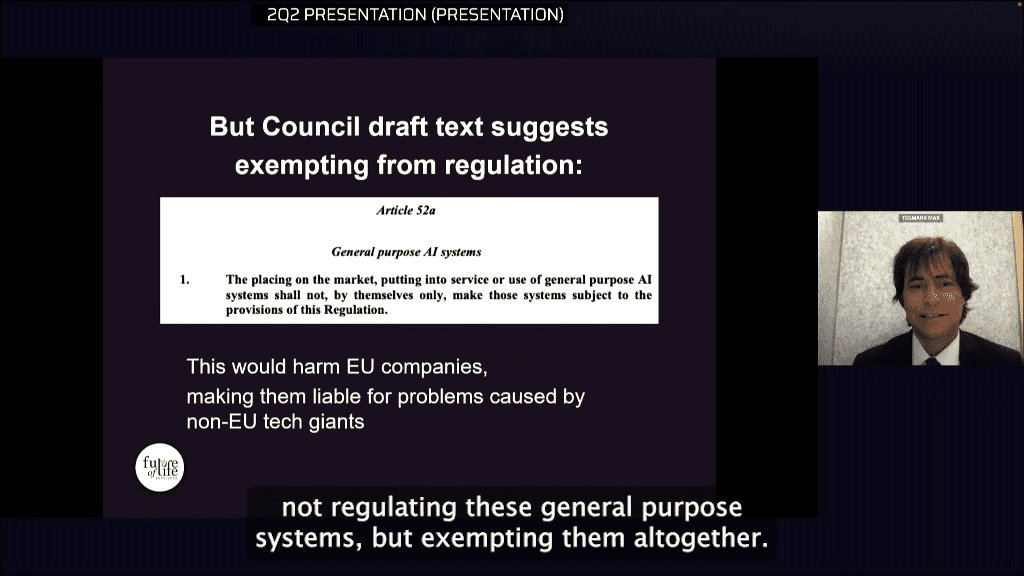

Renforcement du règlement européen sur l'IA

Sensibilisation aux armes autonomes létales

Gouvernance mondiale de l'IA à l'ONU

Derniers documents de politique générale

RfC on BIS Rule for 'Establishment of Reporting Requirements for Advanced AI Models and Computing Clusters' (en anglais)

Passer de la vision à l'action : Mise en œuvre de la feuille de route du Sénat sur l'IA

Amendements recommandés aux propositions législatives sur les "Deepfakes"

Réponse du FLI à l'OMB : demande d'informations sur l'acquisition responsable d'intelligence artificielle au sein du gouvernement

Télécharger la suite

Cible géographique

Où nous trouver

États-Unis

Union européenne

Nations Unies

Réalisations

Quelques-unes de nos réalisations

Élaboration des principes d'Asilomar en matière d'IA

Recommandation sur l'IA dans la feuille de route des Nations Unies sur la coopération numérique

Témoignage de Max Tegmark devant le Parlement européen

Articles à la une

Petit-déjeuner sur la sécurité de l'IA à Paris #2 : Dr. Charlotte Stix

La Chambre des représentants des États-Unis demande la mise en place d'une responsabilité juridique pour les "Deepfakes".

Déclaration sur le veto du projet de loi californien SB 1047

Panda contre aigle

Agences fédérales américaines : Cartographie des activités d'IA

Petit-déjeuner sur la sécurité de l'IA à Paris #1 : Stuart Russell

L'Artist Rights Alliance et Annie Lennox s'expriment dans le cadre de la campagne "Ban Deepfakes".