Benefits & Risks of Artificial Intelligence Korean

Contents

인공 지능의 이점과 위험

“우리가 문명에 대해 동경하는 모든 것은 지능의 산물이므로 인공지능으로 인해 인간의 지능을 넓히는 것은 우리 문명이 번성하도록 돕는 무한한 잠재력이 있다 – 단, 그 기술이 유익한 상태를 유지하는 한 말이다.”

Max Tegmark, 퓨쳐 오브 라이프 인스티튜트 (Future of Life Institute, 이하 FLI)

Click here to see this page in other languages: English![]() Chinese

Chinese ![]() French

French ![]() German

German![]() Japanese

Japanese ![]() Russian

Russian ![]()

인공 지능 (이하 AI) 이란 무엇인가?

Siri부터 자율주행차에 이르기까지 AI는 빠르게 발전하고 있습니다. 공상 과학 소설들은 종종 인공 지능을 인간과 유사한 특징을 가진 로봇으로 묘사하지만 인공 지능은 구글의 알고리즘부터 IBM 왓슨, 그리고 자율 무기에 이르기까지 아주 다른 모습으로 사용되고 있습니다.

오늘날의 인공지능은 얼굴 인식이나 인터넷 검색, 또는 자동차 운전 등 특정 부문을 수행하도록 설계되어있기 때문에 “제한된 AI” (narrow AI)라고 불립니다. 제한된 AI 는 체스를 하거나 방정식을 풀 때와 같이 특화된 작업에서 인간보다 우위에 있지만 많은 연구자의 장기적인 목표는 거의 모든 인지 작업에서 인간보다 우월한 “포괄적 AI” (general AI)를 만드는 것입니다.

AI의 안전성을 연구하는 이유

단기적으로 바라봤을 때 검증, 타당성, 보안 및 통제와 같은 기술적인 주제부터 경제와 법률과 같은 주제들에 이르기까지 AI의 사회 혜택 적 영향을 유지하려는 목표는 많은 분야에 있어서 연구를 촉진합니다. 개인 노트북이 다운되거나 해킹당하는 경우는 사소한 불편에 그칠 수 있지만, AI 시스템이 우리의 자동차, 비행기, 심장 박동기, 자동거래 시스템 그리고 전원장치를 제어한다면 인공지능의 작동 여부는 더 중요해집니다. 또 다른 단기 과제는 치명적인 자동화 무기의 치열한 무기화 경쟁을 막는 것입니다.

장기적으로 더 중요한 질문은 포괄적 AI의 개발이 성공하여 AI시스템이 모든 인지 작업에서 인간보다 우월 해지면 어떻게 될 것인가입니다. 1965년 어빙 존 굿 박사가 지적했듯이 더욱 똑똑한 AI를 디자인 하는 것 자체가 인지 작업이므로, 그러한 시스템은 끝없는 자기 계발을 통해 폭발적인 속도로 인간의 지능보다 훨씬 앞서갈 수 있습니다. 혁신적인 신기술을 발명함으로써 AI의 초지능은 전쟁, 질병, 그리고 빈곤 문제들을 해결하는 데 도움을 줄 수 있으므로 포괄적 AI의 탄생은 인류 사상 가장 큰 사건이 될 수도 있습니다. 하지만 몇몇 전문가들은 우려를 표합니다. AI가 인간의 지능을 확연히 뛰어넘기 전에 AI의 목표를 우리의 목표와 일치시키지 않는 한, 포괄적 AI의 탄생은 인류의 마지막이 될지도 모릅니다.

포괄적AI 의 개발 성공 여부에 의문을 제기하는 사람들이 있지만, AI의 초지능이 인간에게 분명 이로울 것이라고 주장하는 사람들도 있습니다. 이러한 가능성이 존재하지만 저희 FLI는 인공지능 시스템이 의도적으로 또는 의도하지 않게 크나큰 피해를 줄 가능성도 주시하고 있습니다. 우리는 오늘날의 연구가 미래의 잠재적 참사를 예방할 수 있도록 함으로써 인류가 인공지능의 혜택을 전적으로 누릴 수 있을 거라고 믿습니다.

AI의 위험

대부분의 연구자은 초 지적 AI가 사랑이나 증오와 같은 인간의 감정을 나타내지 않을 것이므로 AI가 의도적으로 선하거나 악해질 이유가 없다는 데 동의합니다. 하지만 AI가 위험 요소가 될 수 있는 시나리오들을 고려해봤을 때 전문가들은 가장 가능성이 높은 두 가지 시나리오를 꼽습니다:

- AI가 치명적인 작업을 하도록 프로그램되어있는 경우: 예를 들어 자율병기들은 살상하도록 프로그램되어있는 인공지능 시스템이므로 이 무기의 잘못된 사용은 대량의 사상자를 쉽게 유발할 수 있습니다. 더욱이 인공지능 무기 경쟁이 우발적으로 AI 전쟁을 초래한다면, 이 무기들은 적들의 방해를 피하고자 임무를 중단하는 것이 극히 어렵도록 설계 될 수도 있으므로, 인간은 그러한 상황을 통제할 수 없게 될 수 있습니다. 이러한 위험은 제한된AI의 한해서도 존재하지만 높아지는 AI의 지능과 자율 수준에 따라 증가합니다.

- AI가 유익한 작업을 하도록 프로그램되어있지만 목표 달성을 위해 파괴적인 방법을 사용하는 경우: 이 경우는 인공지능의 목표를 우리의 목표와 완벽하게 일치시키지 못하였을 때 일어날 수 있습니다. 예를 들어 자율 자동차에게 공항으로 가능한 가장 빨리 데려다줄 것을 요구한다면 우리의 요구를 문자 그대로 받아들여 우리는 헬리콥터에 쫓기며 차멀미를 하는 고생을 해야 할지도 모릅니다. 다른 예로는 만약 초지능 AI가 지구공학 프로젝트에 투입된다면 생태계를 파괴하는 부작용이 발생할 수 있으며, 그 부작용을 막으려는 인간의 노력을 AI는 목표 달성에 대한 위협으로 받아들일 수도 있습니다.

위의 예에서 알 수 있듯이 초지능 AI에 대한 우려는 인공지능의 악의가 아니라 능력입니다. 초지능 AI는 목표를 달성하는 데 매우 뛰어남으로 그 목표가 우리의 목표와 일치하지 않는다면 큰 문제가 발생할 수 있습니다. 당신은 아마 악의에 차 개미들을 짓밟는 개미 혐오자는 아니겠지만 당신이 친환경 수력 발전 프로젝트를 담당하고 있다면 대상 지역에 개미집의 존재 여부는 중요하게 생각하지 않을 겁니다. 인공지능의 안전성 연구의 주요 목표는 인류가 홍수에 쓸려 내려갈 개미들처럼 되기까지 내버려 두지 않는 것입니다.

최근 AI안전에 관심을 두는 이유

스티븐 호킹, 일론 머스크, 스티브 워즈니악, 빌 게이츠 및 과학 기술 분야의 많은 유명인사와 인공지능 연구자들이 언론과 공개서한을 통해 AI의 위험에 대한 우려를 표명했습니다. 이 주제가 갑자기 화제가 된 이유는 무엇일까요?

포괄적 인공지능의 개발 성공은 오랫동안 공상 과학 소설, 혹은 아주 먼 미래라고 생각되어 왔습니다. 그러나 기술의 빠른 발달을 통해 5년 전만 해도 수십 년이 걸릴 거라고 예상한 인공지능의 발전이 오늘날 이미 이루어져 많은 전문가은 인공지능의 가능성을 숙고하고 있습니다. 일부 전문가들은 아직도 인간 수준의 AI는 수 세기 후의 일이라고 여기지만, 2015년 푸에르토 리코에서 열린 컨퍼런스에서 대다수의 연구원들은2060년 이전에 성공하리라 추측했습니다. 따라서 필요한 안전성 연구를 마치는 데에 수 십년이 걸릴 수 있으므로 지금 그 연구를 시작해야 합니다.

인공지능은 그 어떤 인간보다 더 똑똑해질 가능성이 있으므로 인간의 지능으로는 AI가 어떻게 행동할지 예측할 수 있는 확실한 방법이 존재하지 않습니다. 우리가 고의로 혹은 의도치 않게 우리를 능가할 수 있는 능력을 갖춘 것을 만들어 본 적이 아직 없기 때문에 우리는 과거의 기술을 바탕으로 대처할 수도 없습니다. 우리가 이해할 수 있는 가장 좋은 예는 우리 자신의 진화 일수도 있습니다. 인간은 가장 크거나, 힘이 세거나 가장 빨라서가 아니라 가장 똑똑하기 때문에 지구를 지배하는 것인데, 우리가 더이상 가장 똑똑한 종족이 아니게 된다면 우리가 지구를 계속 지배할 수 있다고 확신할 수 있을까요?

FLI의 입장은 끝없이 성장하는 기술력과 그 기술을 통제하는 우리의 지혜 사이의 경쟁에서 우리가 승리하는 한, 우리의 문명은 번창할 것이라는 것입니다. 인공지능 기술에 있어서 승리하는 가장 좋은 방법은 AI안전성 연구를 지원함으로써 기술의 발전을 방해하는 것이 아니라 우리의 지혜를 늘리는 것입니다.

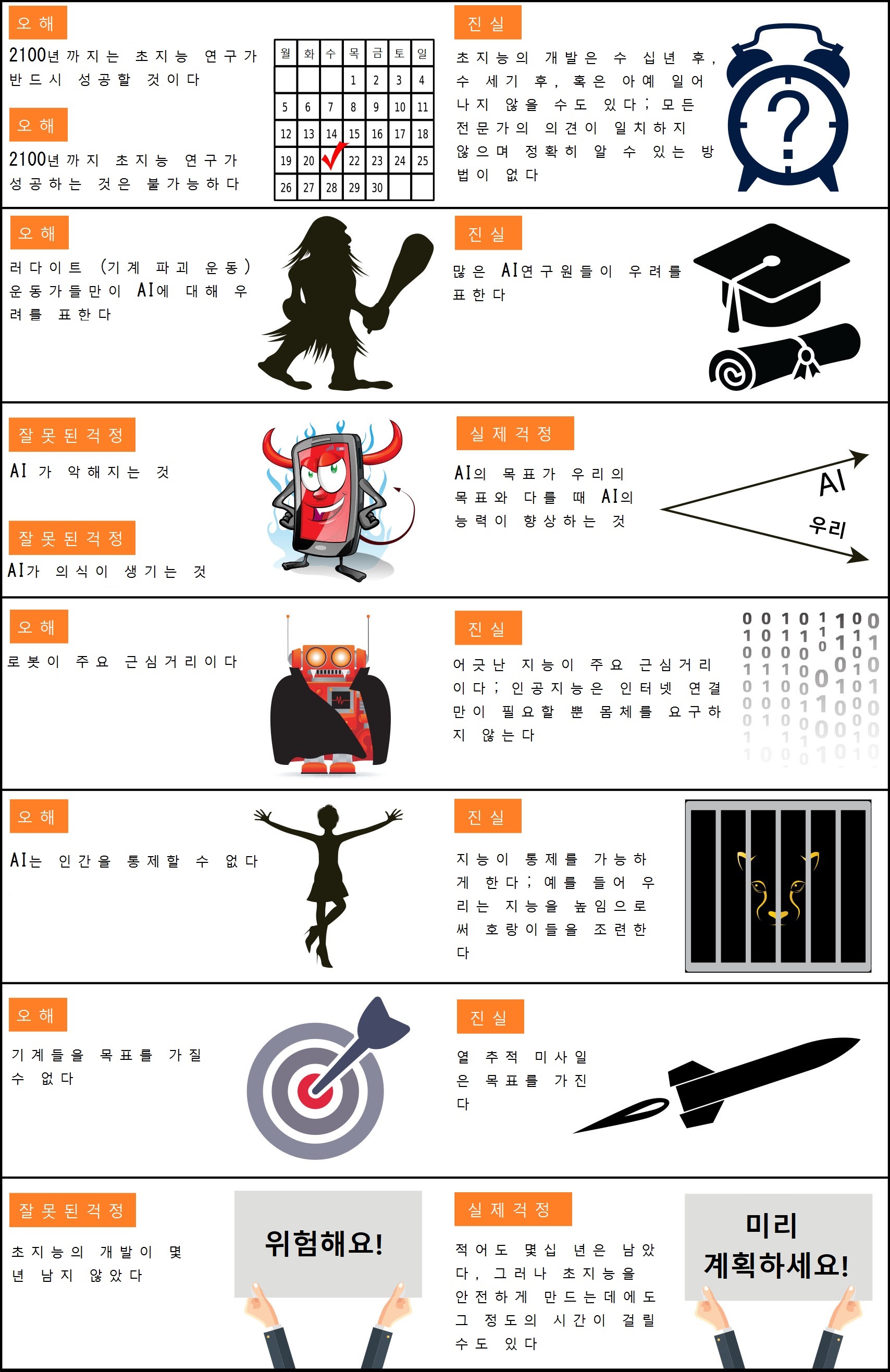

초지능 AI에 관한 오해

인공지능의 미래와 그것이 인류에게 어떤 의미가 될 것인지 또는 어떤 의미가 돼야 할 것인지에 대해 많은 대화가 오가고 있습니다. 세계 전문가들은 AI가 고용 시장에 미치는 영향, 인간 수준의 AI 개발 성공 여부와 때, 이것이 폭발적 지능으로 이어질 것인가의 여부, 그리고 우리가 AI개발을 환영으로 혹은 두려움으로 맞이해야 할 여부 등, 많은 분야에서 논쟁을 벌이고 있습니다. 하지만 사람들의 오해와 동문서답으로 지루하고 의미 없는 논쟁들도 흔하게 발생하고 있습니다. 더 유익하고 흥미로운 질문들에 초점을 맞추기 위해 가장 일반적인 오해들을 정리해 봤습니다.

시간에 관한 오해

기계가 인간의 지능을 능가할 때까지 얼마나 걸릴까요? 우리는 일반적으로 우리가 그 답을 확실히 알고 있다고 오해합니다.

일반적인 착각 중에 하나는 우리가 금세기에 초인적 인공지능을 얻을 것이라는 확신입니다. 사실, 역사는 기술에 대하여 과장된 광고와 목표로 가득 차 있습니다. 지금쯤이라면 발명될 것이라고 약속된 핵융합 발전소와 날아다니는 자동차들은 어디있을까요? 인공지능 또한 예부터 지속적으로 과장되어 왔습니다. 예를 들어, 인공지능의 창시자들, 존 맥카티 (“인공지능”이라는 단어를 창조한 사람), 마빈 민스키, 나타니엘 로체스터와 클라우드 섀넌은 구식 컴퓨터로 지나치게 낙관적인 예측을 했습니다: “1956 여름, 열 명의 연구자들이 다트머스 대학에서 두 달 동안 인공지능 연구를 진행할 것입니다 […] 기계들이 언어를 사용하고, 추상과 개념을 형성하고, 인간들만이 해결할 수 있는 문제들을 해결하며, 자기 자신을 향상할 수 있도록 만드는 방법에 대한 시도를 할 것입니다. 우리는 엄선된 과학자들이 여름 동안 협력한다면 이러한 몇몇 문제들에서 상당한 진전을 이룰 수 있다고 생각합니다.”

반면에 이와 반대되는 일반적 착각은 우리가 초인적 AI를 얻지 못할 것이라는 확신입니다. 연구원들은 우리가 초인적 인공지능의 개발이 얼마의 시간이 걸릴지에 관한 많은 견적을 냈지만, 역사적으로 많은 회의론적인 예측들의 정확도를 따져봤을 때, 금세기에 초인적 AI 개발확률이 0이라고 분명히 말할 수는 없습니다. 예를 들어, 위대한 핵 물리학자 어니스트 러더포드는 레오 실라드가 핵 연쇄 반응을 개발하기 불과 24시간 전에 원자력은 헛소리라고 말했으며, 천문학자 로열 리처드 울리는 행성 간 여행이 부질없는 이야기라고 1956년도에 말했습니다. 이 오해의 가장 극단적인 형태는 초인적 인공지능이 물질적으로 불가능하다는 것입니다. 그러나 물리학자들은 두뇌가 쿼크와 전자로 구성되어 강력한 컴퓨터와 같이 작동하도록 설계되어 있다는 것을 알고 있으며, 그러므로 더욱더 지능적인 쿼크 조직을 만드는 것을 방해하는 물리적 법칙은 없다는 것도 알고 있습니다.

인공지능 연구원들에게 ‘지금부터 몇 년 후에 인간 수준의 인공지능이 적어도 50%의 확률로 개발될 것인가’라고 설문조사를 실행했을 때, 이러한 모든 설문조사의 결론은 ‘세계적인 전문가들의 의견이 다르므로 알 수 없다’ 였습니다. 예를 들어, AI연구원들을 대상으로 한 설문조사에서 평균 답변은 2045년이었지만, 일부 연구원들은 수백 년 이상으로 예측했습니다.

이와 관련된 또 다른 오해는 초인적 인공지능의 개발이 몇 년 밖에 걸리지 않는다고 생각하는 것입니다. 사실상 초인적 인공지능에 대해 걱정하는 사람들은 적어도 10년 이상은 남아 있다고 추측합니다. 하지만 금세기에 일어나지 않을 것이라고 100% 확신하지 않는 한, 우발적 상황에 대비하기 위해 지금 안전 연구를 시작하는 것이 현명하다고 그들은 주장합니다. 인간 수준의 인공지능과 관련된 안전성의 문제들은 굉장히 까다롭고 어려우므로 해결하기까지 수십 년이 걸릴 수 있습니다. 그러므로 위험이 일어나기 하루 전보다 지금 당장 연구를 시작하는 것이 현명합니다.

논란의 소지에 관한 오해

또 다른 흔한 오해는 AI의 관해 우려를 표하는 사람들과 안전성 연구를 지지하는 모든 사람들은 인공지능에 대해 많이 알지 못하는 러다이트 운동가들이라고 믿는 것입니다. 이 주장을 AI 교과서의 저자 스튜어트 러셀이 푸에르토리코에서 언급하여 청중의 큰 웃음을 샀습니다. 이것과 연관되어 몇몇의 사람들은 AI의 안전성 연구를 지지하는 것이 논란의 여지가 많다고 착각합니다. 하지만 집에 불이 날 수도 있다는 가능성을 무시하지 못하여 화재보험을 드는 것과 같이, 사실 AI안전성 연구를 지원하기 위해서는 위험성이 높다는 확신보다는 단지 그 위험이 무시할 수는 없을 정도라는 사실에 대한 이해만이 필요합니다.

언론에 의해 AI의 안정성에 대한 논쟁이 실제보다 더 논란이 되는 것처럼 보일 수도 있습니다. 우리의 두려움은 마케팅에 자주 이용당하고 문맥 밖의 암시적 인용문들이 사실적인 인용문들보다 클릭 수를 높이는 것은 사실입니다. 그렇기 때문에 양측이 미디어를 통해서만 접촉한다면, 실제보다 더 의견이 대립한다고 생각할 수 있습니다. 예를 들어 기술발달에 관하여 회의론적 성향을 가지고 있는 사람이 영국 신문만을 통해 빌 게이츠의 입장을 읽는다면, 게이츠가 초지능의 개발이 임박했다고 믿고 있다고 잘못 판단할 수도 있습니다. 마찬가지로 AI의 유익함을 주장하는 사람이 앤드류 응의 입장에 대해 전혀 모른 상태로 그의 화성 인구 과잉에 관한 인용문만 읽었다면, 실수로 앤드류 응이 AI안전에 신경을 쓰지 않는다고 생각할 수 있습니다. 앤드류 응은 인공지능의 발달을 길게 보기 때문에 장기적인 문제들 보다 단기적인 것들에 중점을 두기 때문입니다.

초인적 AI의 위험에 관한 오해

“스티븐 호킹, 로봇의 부상은 인류에게 재앙.” 많은 AI연구자들은 이 머리기사를 보고 어이없어합니다. 이와 비슷한 제목의 기사들은 그 수를 헤아릴 수 없을 정도입니다. 일반적으로 이런 기사들은 나쁘게 묘사된 로봇 일러스트레이션 등을 통해 우리가 자의식이 생긴 악한 로봇들이 반란하여 우리를 살생하는 것을 걱정해야 한다고 부추깁니다. 이것을 긍정적으로 생각한다면, 이러한 기사는 AI연구자가 걱정하지 않는 시나리오를 간결하게 요약하고 있다는 면에서 사실 인상적입니다. 이 시나리오는 의식에 대한 걱정, 악, 그리고 로봇, 이 세 가지 서로 다른 오해들을 결합하고 있습니다.

도로를 달릴 때 우리는 색깔, 소리 등 주관적인 경험을 합니다. 하지만 자율 자동차도 이러한 주관적인 경험을 할까요? 자율 자동차가 된다는 것이 아무 느낌을 불러올 수 있기는 한 걸까요? 물론 이 의식에 대한 의문점들은 그 자체로도 흥미롭지만, AI의 위험과는 관계가 없습니다. 인간에게 영향을 미치는 것은 초인적 AI가 하는 행동뿐, 인공지능이 느끼는 주관적 감정이 아니기 때문입니다.

기계가 악의적으로 변하는 것에 대한 두려움은 우리를 헷갈리게 하는 또 다른 요인입니다. 우리가 진정으로 걱정해야 할 것은 인공지능의 악의가 아니라 능력입니다. 초인적 인공지능은 목표가 무엇이든 그것을 달성하는 데 매우 뛰어나기 때문에 그 목표가 우리의 목표와 반드시 같아야 합니다. 우리는 보통 개미를 싫어하지 않지만, 개미들보다 똑똑하기 때문에, 우리가 개미집 위에 수력 발전 댐을 짓고 싶다면, 개미들은 어찌할 수 없습니다. 유익한 인공지능을 이룩하려는 노력의 이유는 인류가 홍수에 떠내려갈 개미 처지를 면하기 위함에 있습니다.

자의식에 관한 오해는 기계는 목표를 가질 수 없다는 오해와 연관되어 있습니다. 그러나 열 추적 미사일이 타깃을 맞추는 것과 같이, 기계는 분명 목표 지향적 행동을 나타낸다는 의미에서 목표를 가질 수 있습니다. 따라서 엇나간 목표를 가진 기계가 위협적이라면, 그 위협의 근원지는 기계의 자의식 여부가 아닌 엇나간 목표 그 자체입니다. 만약 열 추적 미사일이 쫓아온다면, 아마 우리는 기계가 목표를 가질 수 없기 때문에 걱정하지 않아도 된다고 자신만만하지는 않을 겁니다.

몇몇 기자들은 로봇에 집착하여 자신의 기사를 사악한 금속 괴물들로 가득 채우기 때문에 그들은 종종 로드니 브룩스와 다른 로봇 연구 선구자들을 악마처럼 묘사합니다. 사실 주된 걱정거리는 로봇이 아니라 지능 그 자체, 더 구체적으로 말하자면, 우리의 목표와 엇나간 지능입니다. 이런 엇나간 초인적 지능이 금융시장을 뛰어넘고, 인간 연구원들보다 앞서가며, 인간 지도자들을 능가하고, 우리가 이해하지도 못하는 무기들을 생성하는 데에는 단지 인터넷 연결만 필요할 뿐, 로봇 몸체는 필요하지 않습니다. 따라서 로봇을 만드는 것이 물리적으로 불가능하다고 해도, 뛰어난 지능과 부를 가진 AI는 쉽게 인간들을 조정하거나 돈을 지급하여 인간들이 무의식적으로 명령을 복종하도록 만들 수 있습니다.

로봇에 대한 오해는 기계들이 인간을 조종할 수 없을 것이라는 착각과 관련이 있습니다. 하지만 지능은 통제를 가능하게 합니다. 우리가 호랑이를 통제할 수 있는 것은 우리가 더 강해서가 아니라 우리가 더 지능적이기 때문입니다. 그렇기 때문에 지구에서 최상위인 우리의 지적 위치를 양보한다면, 우리가 가지고 있던 통제 능력도 함께 양보해야할지도 모릅니다.

흥미로운 논쟁들

위에 언급된 오해들에게 시간을 허비하지 않아야만 흥미롭고 진실된 논쟁들에 집중할 수 있습니다. 당신은 어떤 미래를 원하십니까? 우리는 치명적인 자율 무기를 개발해야 할까요? 기계에 의한 직업 자동화에대해 어떻게 생각하십니까? 오늘날의 아이들에게 어떤 진로 상담을 해주시겠습니까? 새로운 직업들이 오래된 직업들을 대체하기를 원하십니까 아니면 모두가 풍족한 삶을 누리는 직업 없는 사회를 원하십니까? 더 나아가 초지능이 개발되 온 우주에 퍼지기를 원하십니까? 우리가 그 지능적 기계들을 통제할까요 아니면 그들이 우리를 통제할까요? 지능적 기계들이 과연 우리를 대체할까요, 우리와 공존할까요, 혹은 우리와 통합할까요? 인공지능 시대에 인간으로 존재한다는 것은 어떤 의미일까요? 어떤 의미이기를 바라십니까? 그리고 어떻게 미래를 그렇게 만들 수 있을까요? 이러한 질문들에 의문을 가지신다면 지금 이 대화에 참여하세요!

About the Future of Life Institute

The Future of Life Institute (FLI) is a global non-profit with a team of 20+ full-time staff operating across the US and Europe. FLI has been working to steer the development of transformative technologies towards benefitting life and away from extreme large-scale risks since its founding in 2014. Find out more about our mission or explore our work.