人工智能是否应受管制?

Contents

Click here to see this page in other languages: English ![]()

作者安东尼·阿吉雷(Anthony Aguirre),阿里尔·康尼(Ariel Conn)和马克斯·泰格马克(Max Tegmark)

人工智能(AI)应受到管制吗?能否被管制吗?如果可以,相关条例应如何制定?

对于仍然处于发展阶段的任何技术来说,这些都是难以回答的问题。比如管制食品、药物、汽车和航空等行业的条例,多于不良情况发生之后才得以实施,而不是在预测技术即将造成危险之后而实施。但因为人工智能发展迅速,潜在的影响力非常大,所以多数人倾向于事先制定好相关管制条例,而不是等待事故发生后再从错误中学习。

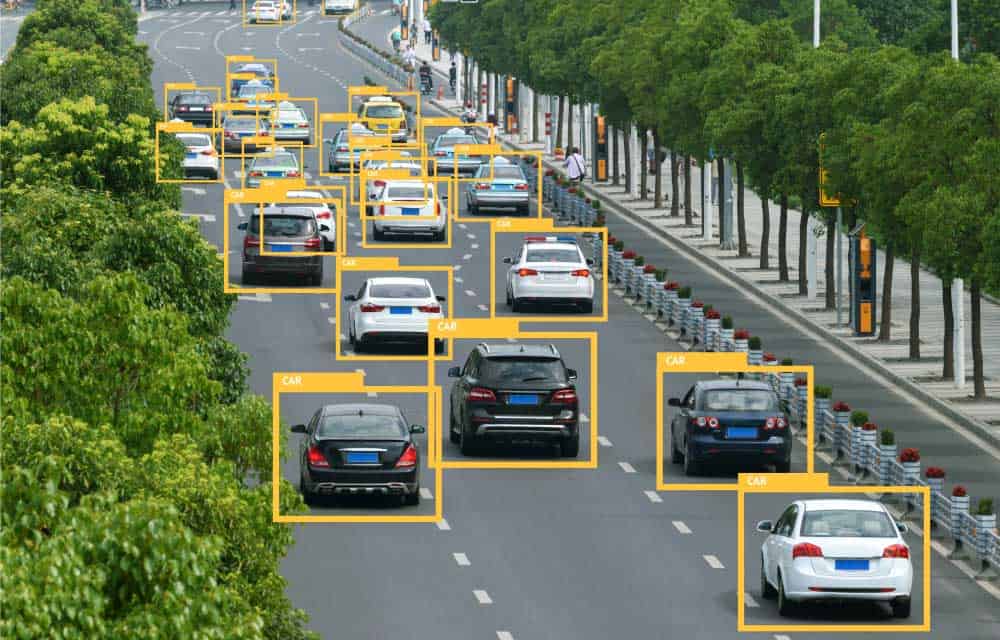

近期而言,和许多新技术一样,政策制定者需要加以关注失业、无人驾驶汽车、AI和算法决策以及驱动社交媒体的“聊天机器人”等领域。从长远来看,AI可能会影响到人类的所有利益和风险- 从可能迈向发展乌托邦社会到人类文明潜在的灭绝前景。因此,对于未来的监管机构来说,这种情况特别具有挑战性。

如今,许多AI工作者正在努力确保人工智能的研发是有益的,并且不对研发人员设立不必要的限制。今年1月,AI界的一些精英在加州阿西洛马的会议中碰面,并制订了《阿西洛马人工智能原则》。起草者希望通过这23项原则在一定程度上确保AI的研发能让所有人收益。迄今为止,已有超过1200名AI研究人员和2300名相关人士签署了该原则。

然而,倘若不能付诸实践,光有这些鼓舞人心的原则是不够,且有一个问题尚未解决:是否需要政府的管制和监督来保证AI科学家和公司遵守这些原则和其他类似的规定?

《阿西洛马人工智能原则》的签署人之一,伊隆·马斯克(Elon Musk),在最近全美州长协会上的发言引起了人们的关注。他呼吁监管机构对AI的发展进行监督。新闻机构对他就AI代表了一种存在性威胁的担忧表示了关注。他的提议也引发了一些AI研究人员的顾虑。他们担心管制,即使在最乐观的情况下,也会毫无益处并带来误导;最糟糕的情况是,管制将扼杀创新,使海外公司获利。

其中,马斯克一个重要的观点却被忽略了。即监管机构实际上应该做什么,他说:

“正确的流程应该是设立监管机构——初级目标:深入了解AI活动的状况,确保足够理解,完成以上步骤后,应制定相关政策以确保公众安全。总而言之,我的意思是要确保政府对此事有一定关注。”

AI研究人员对于AI的风险是什么、风险可能何时发生以及AI是否可能构成存在性风险等方面存在分歧,但几乎没有研究人员认为AI并不存在任何风险。目前,我们能够看到一些弱AI加剧歧视和失业等问题。随着AI变得日益智能及复杂,我们可以预料到如果不采取适当的预防措施,以上问题便会恶化,从而影响到更多人。

签署《阿西洛马人工智能原则》以及关于开发有益AI和反对致命自主武器公开信的研究人员人数众多。这表明研究人员们对于该问题已达成强烈共识 – 我们需要更深入了解及解决AI已知和潜在的风险。

AI研究人员签署的一些原则直接涉及到马斯克的声明,其中包括:

3)科学与政策的联系:在人工智能研究者和政策制定者之间应该有建设性及有益的交流。

4)研究文化:AI的研究人员和开发人员应该培养合作、信任和透明的文化。

5)避免竞争:人工智能系统开发团队之间应该积极合作,以避免在安全标准上偷工减料。

20)重要性:高级人工智能能够代表在地球上生命历史的一个深刻变化,人类应该有相应的关切和资源来进行计划和管理。

21)风险:AI系统造成的风险,特别是灾难性或存在性风险,必须遵循与其预期影响相当的规划和减缓措施。

正确的政策和管理方案可以指导AI的发展与以上原则相称。同时,这也能鼓励为实现该目标的跨学科对话。

最近成立的“AI”伙伴关系,包括主要的AI行业参与者,同样赞同按照原则进行AI开发的想法,他们的创始文件指出,“我们必须确保任何用AI工具以补充或取代人类决定的场合是安全可靠的,并且确保其行为符合被影响的人们的道德与偏好”。

正如马斯克所提议,第一步需要提高政府官员对AI影响的意识。例如,无人驾驶汽车预计将取代数百万个工作岗位,这几乎会影响到参加会议的每个州长(假设他们仍然在任职),但是这个话题很少在政治讨论中出现。

AI研究人员对AI能够提高人们健康和生活素质的惊人潜力而感到非常兴奋-这理所应当,也是最初大多数人加入该领域的原因。但是,对于可能滥用和/或设计不良的AI,特别当我们迈向更智能更普遍的AI,我们的担忧也是合理的。

因为这些问题会威胁到整个社会,所以我们不能把这些问题只留给一小部分研究人员来解决。政府官员至少需要了解并清楚AI会怎样影响其选民,以及AI安全研究将如何帮助我们在出现问题之前解决它们。

我们应帮决策者理解AI进程的实际意义和影响,而不是着眼于规定本身的好坏,为今后的建设性管制奠定基础。扪心自问:我们如何才能确保AI有益于所有人?又有哪些人应该参与此项工作?

About the Future of Life Institute

The Future of Life Institute (FLI) is a global non-profit with a team of 20+ full-time staff operating across the US and Europe. FLI has been working to steer the development of transformative technologies towards benefitting life and away from extreme large-scale risks since its founding in 2014. Find out more about our mission or explore our work.